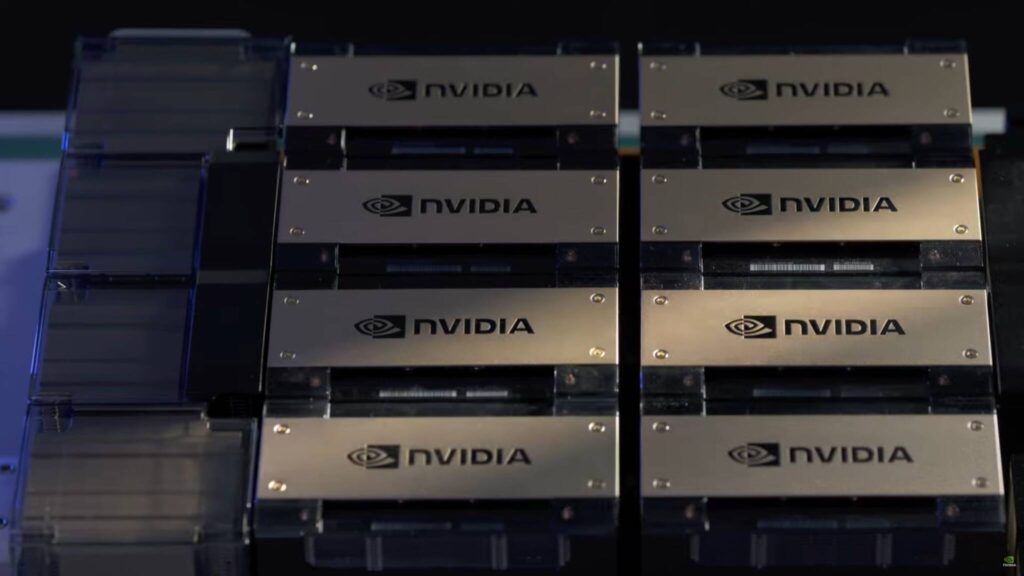

NVIDIAは、世界初のDGX H200 AIステーションをOpenAIに納入し、ジェンセン・フアン最高経営責任者(CEO)本人から手渡された。

NVIDIAはまだその大きな成長を止めるつもりはなく、AIの次の時代を促進するために、OpenAIに最初のDGX H200 AIステーションを提供する。

OpenAIの社長兼共同設立者であるグレッグ・ブロックマン氏によるXの投稿で、チーム・グリーンが同社の最も強力な製品をついにOpenAIに引き渡したことが明らかになった。

興味深いことに、NVIDIAのジェンセン・フアンCEOは、技術的な驚異と呼ぶべきものを届けるために到着した。

OpenAIのCEOであるサム・アルトマンとグレッグ・ブロックマンもNVIDIAのパッケージを受け取っており、DGX H200が確かに注目を集める出席者を必要とする巨大なものであることを示している。

First @NVIDIA DGX H200 in the world, hand-delivered to OpenAI and dedicated by Jensen "to advance AI, computing, and humanity": pic.twitter.com/rEJu7OTNGT

— Greg Brockman (@gdb) April 24, 2024

DGX H200が何を提供するかに入る前に、業界のダイナミクスについて説明しよう。

OpenAIが世界で最も強力なAIシステムへの独占アクセスを得たという事実とは別に、優れたハードウェアを世に送り出すために各社がどのように争っているのかを目の当たりにするのは興味深い。

最近、我々はBlackwell GPUについて少し話したが、大衆市場にはリリースされていないにもかかわらず、Metaが次世代アーキテクチャの最初の注文を出した。

一方、巨大データセンターの構築に注力するOpenAIは7兆ドルの評価額を提示しているが、これ以上は触れない。

1つ目は、企業間の将来的な競争は、AIの収益ではなく、搭載されているコンピューティング・パワーであるということ。

もうひとつは、象徴的なレザージャケットを身にまとったこの男は、今しばらく業界のスポットライトを浴びるだろう、ということだ。

チーム・グリーンが顧客に提供する強固なエコシステムは、まさに驚くべきものである。

DGX H200に話を戻すと、この野獣のようなマシンはHBM3Eの性能によって駆動される。

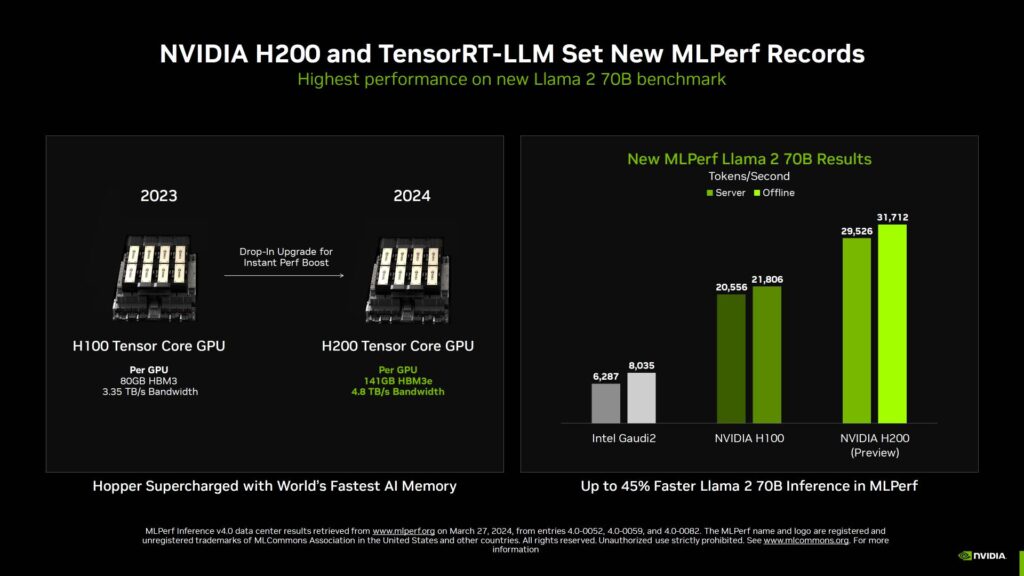

最大141GBのメモリ容量と最大4.8TB/秒の帯域幅を持ち、これは従来の2.4倍の帯域幅と2倍の容量である。

最近の取材では、H200sが市場よりも優れていることを強調し、MLPerf v4.0などのAIアプリケーションでほぼ2倍の性能を発揮することに成功したことを紹介し、これらのハードウェアが市場セグメントでいかに優位に立っているかを示した。

興味深いことに、DGX H200は、新しいBlackwell B100/B200 GPUに引き継がれたHopperアーキテクチャをベースにしている。

これらの次世代AIチップは、AI性能と能力を向上させ、今年後半には実戦投入される可能性が高い。

ソース:wccftech - NVIDIA’s CEO Jensen Huang Delivers World’s First DGX H200 AI Station To OpenAI

解説:

NVIDIAがOpenAIにH200を真っ先に納品

これが究極の商売の姿

納品なので当然お金は払っていると思うのですが、真っ先に納品されただけでニュースになり、お金を払った相手から感謝される、これが究極の商売の姿です。

大金を払っても「売ってくれてありがとう」素晴らしい商売だと思います。

さて、これでOpenAIのデータセンターも処理能力が向上しましたので、また新しい画期的なサービスが世に出てくるのではないかと思います。

今年までは2年に一度でしたが、今年からは毎年新製品が発売されるということですので、AI/MLハードウェアアクセラレーターの進化に伴って、ソフトウェアの進化も加速していくことでしょう。

動画生成AI Soraの次は何が登場するのでしょう。

民生用のGPUとはまた差がついてしまいましたね。