新興企業のCelestial AIは、DDR5とHBMメモリーを利用してチップレットの効率を高める新しい相互接続ソリューションを開発した。

Celestial AIは、HBMとDDR5メモリを組み合わせたシリコンフォトニクスの提供により、従来の相互接続に関連する障壁を打破することを計画している。

半導体のように、世代進化はAI業界にとって必要以上になってきており、それはハードウェアセグメント内の進歩であれ、相互接続方法であれ同様である。

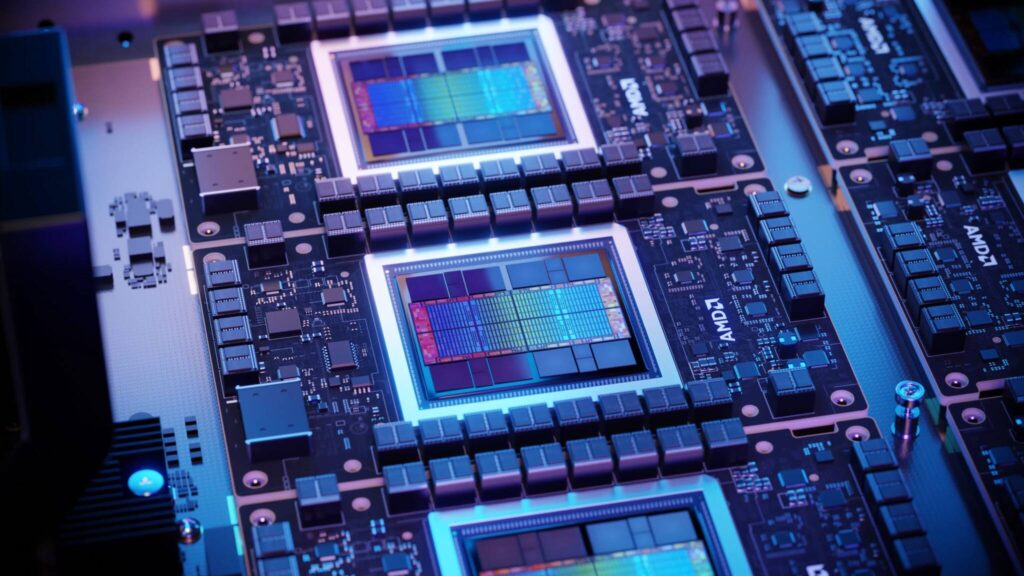

何千ものアクセラレーターを接続する従来の方法には、NVIDIAのNVLINKや従来のイーサネット方式、さらにはAMD独自のInfinity Fabricなどがある。

しかし、インターコネクトの効率性だけでなく、拡張の余地がないため、業界は代替手段を見つけることになった。

以前の記事で、シリコンフォトニクスの重要性と、レーザーとシリコン技術を組み合わせたこの技術が相互接続の世界で次の大きなものになったことを述べた。

Celestial AIは、この技術を活用し、フォトニック・ファブリック・ソリューションを開発した。

同社の共同設立者であるデイブ・ラゾフスキーによると、同社のフォトニック・ファブリックは、潜在顧客の間で大きな関心を集めることに成功し、最初の資金調達ラウンドで1億7500万ドルを得ただけでなく、AMDなどからも支援を受けたという。

当社のフォトニック・ファブリックに対する需要の急増は、適切なテクノロジー、適切なチーム、そして適切な顧客エンゲージメント・モデルの賜物です」。

- Celestial AI共同設立者 デイブ・ラゾフスキー

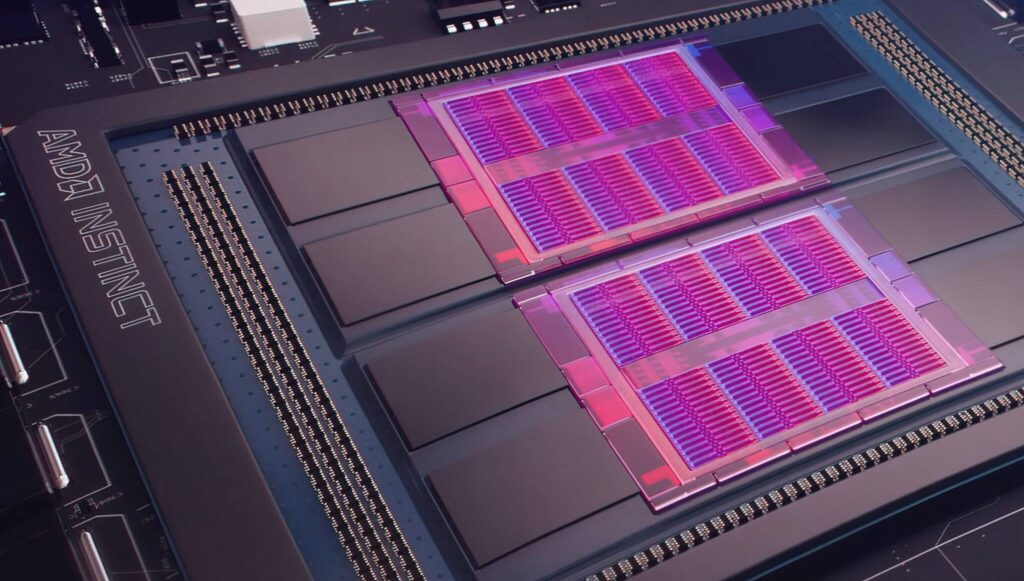

フォトニック・ファブリックの能力に話を移すと、同社は、この技術の第一世代は、1平方ミリメートルあたり1.8Tb/秒を提供できる可能性があり、第二世代では、前世代からなんと4倍も増加することを明らかにしている。

しかし、複数のHBMモデルを積み重ねるとメモリ容量が制限されるため、インターコネクトはある程度制限されるが、Celestial AIはそれに対しても魅力的な解決策を提案している。

同社は、2つのHBMと4つのDDR5 DIMMのセットを積み重ねることで、72GBと最大2TBのメモリ容量を組み合わせ、より大きな容量を達成するために、メモリモジュールの拡張を搭載しているため、HBMスタックとDDR5メモリの使用を統合することを意図しており、DDR5を使用することで、より高い価格対容量比を得ることができ、最終的により効率的なモデルになることを考えると、これは実に興味深い。

Celestial AIは、すべてをリンクさせるインターフェースとしてフォトニック・ファブリックを使用する予定であり、同社はこの方法を「コスト・オーバーヘッドなしで超高速化されたグレース・ホッパー」と呼んでいる。

しかし、Celestial AIは、同社のインターコネクト・ソリューションが市場に出回るのは少なくとも2027年以降になると考えている。

その頃には、シリコンフォトニクス分野で多くの競合企業が出現しているため、Celestial AIが市場に参入するのは容易ではない。

解説:

Celestial AIがチップ間接続の省電力な方式を開発、AMDが次期チップレットで採用か?

インフィニティ・ファブリックのようなもののようですね。

データセンターに納品されような巨大システムは複数のGPUが搭載されているのが当たり前になっていますが、そのようなシステム向けの技術として開発されたのでしょう。

Celestial AIは新興企業のようですが、社名からしてAI技術を活用している企業だと思われます。

AIはこのように効率性や省電力性、処理性能という明確なゴールがあってそこに向かって最適化していくという作業のほうが得意なようです。

アートやイラストのように見るものによって正解が変わってしまうようなものは得意ではないということになります。

効率性を追求するような分野では人間をすでに圧倒しています。

アートでは一流のプロフェッショナルを圧倒するにはしばらく時間が必要かもしれませんが、このようなニュースを見ると時間の問題なのかなと思います。

ここまで書いてきて、このCelestial AIですが、どうやら同様の技術を擁する企業というのは多数あり、Celestial AIの製品が投入される2027年にはライバル製品が多数登場しているだろうとのこと。

AI企業もなかなか厳しい環境にさらされているようです。