NVIDIAは、次世代Hopper GPUの商標を申請するのに苦労しているかもしれませんが、Kopite7kimiからの最新の噂では、このチップは約1000mm2の大きさになると主張しているので、旗艦GH100ダイの開発には支障がないようです。

NVIDIA GH100 GPU、次世代フラッグシップデータセンターチップのサイズは約1000mm2へ

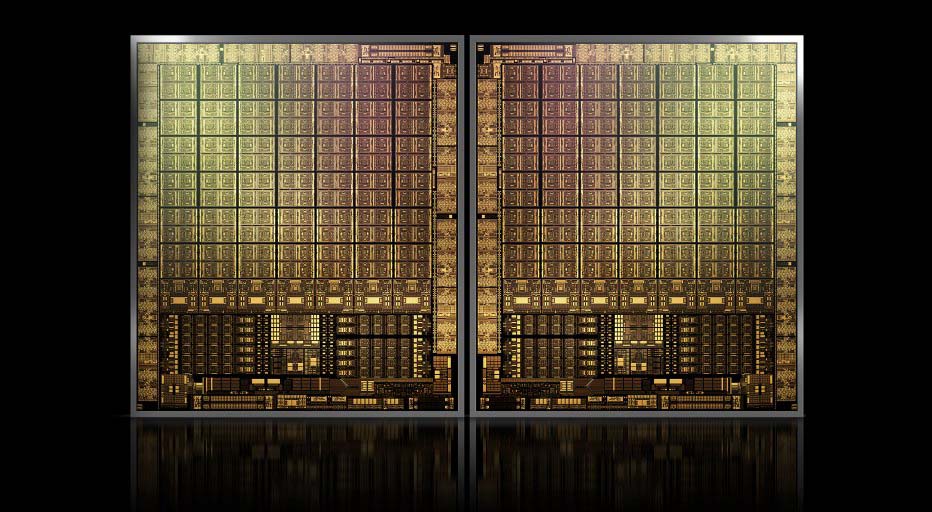

現在、生産されている最大のGPUは、826mm2のNVIDIA Ampere GA100です。もしこの噂が正しければ、NVIDIAのHopper GH100は、1000mm2前後の大きさで、現在のモンスターGPUを少なくとも100mm2上回る、これまでに考えられた最大のGPU設計となるであろう。

しかし、それだけではありません。問題のダイサイズは、GH100 GPUのダイ1個分です。

HopperがNVIDIA初のMCMチップデザインになるという噂を聞いていますので、同じインターポーザーに少なくとも2個のHopper GH100 GPUを搭載すると考えると、ダイだけで2000mm2を計測することになります。

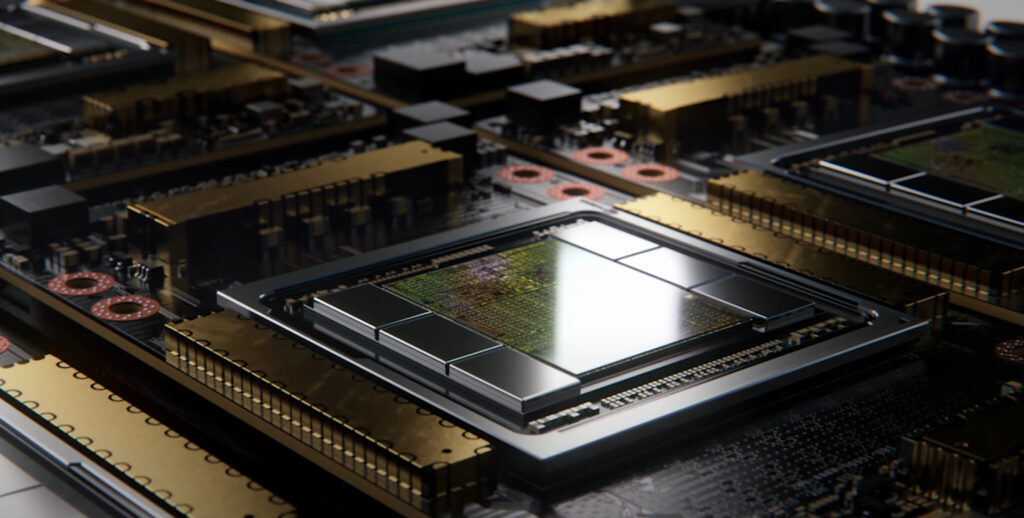

このことから、インターポーザは、複数のHBM2eスタックと他のコネクティビティを搭載することを考えると、我々がまだ見たことがないものよりもはるかに大きくなることが予想されます。

ただし、Greymon55は、Hopperはモノリシックデザインであり続けると述べており、最終的にどのようなチップデザインになるかは未知数である。

GH100 has a huge single die of slightly less than 1000mm².

— kopite7kimi (@kopite7kimi) January 29, 2022

GH100 does not have MCM, it's still monolithic.

— Greymon55 (@greymon55) January 29, 2022

NVIDIA Hopper GPU - これまでに判明していることすべて

これまでの情報から、NVIDIAのH100アクセラレータは、MCMソリューションに基づき、TSMCの5nmプロセスノードを利用することが分かっている。

Hopperは、2つの次世代GPUモジュールを搭載するとされているので、合計で288個のSMユニットを搭載すると見られる。

各SMに搭載されるコア数が不明なので、コア数の内訳はまだわからないが、もしSMあたり64コアにこだわるなら、GA100のフルGPU構成の2.25倍となる18,432コアになると思われる。

NVIDIAは、Hopper GPUで、より多くのFP64、FP16、Tensorコアを活用することもでき、パフォーマンスを大幅に向上させることができるだろう。

そしてそれは、1:1のFP64を搭載すると予想されるIntelのPonte Vecchioに対抗するために必要なものになるでしょう。

最終的には、各GPUモジュールで144個のSMユニットのうち134個を有効にした構成になると思われ、そのため、GH100のダイが1個動作しているように見える可能性が高い。

しかし、GPU Sparsityを使わずに、NVIDIAがMI200と同じFP32やFP64 Flopsに到達することはあり得ない。

しかし、NVIDIAには秘密兵器がありそうで、それはCOPAベースのHopperのGPU実装になりそうだ。

NVIDIAは、次世代アーキテクチャをベースにした2つのドメイン特化型COPA-GPUについて、1つはHPC向け、もう1つはDLセグメント向けだと語る。

HPC向けは、MCM GPU設計とそれぞれのHBM/MC+HBM(IO)チップレットからなる非常に標準的なアプローチだが、DL向けが面白くなり始めるところだ。

DL版では、GPUモジュールと相互接続された全く別のダイに巨大なキャッシュを搭載しています。

| アーキテクチャー | LLC容量 | DRAM帯域 | DRAM 容量 |

| 構成 | (MB) | (TB/s) | (GB) |

| GPU-N | 60 | 2.7 | 100 |

| COPA-GPU-1 | 960 | 2.7 | 100 |

| COPA-GPU-2 | 960 | 4.5 | 167 |

| COPA-GPU-3 | 1920 | 2.7 | 100 |

| COPA-GPU-4 | 1920 | 4.5 | 167 |

| COPA-GPU-5 | 1920 | 6.3 | 233 |

| Perfect L2 | 無限 | 無限 | 無限 |

※ 画像をクリックすると、別Window・タブで拡大します。

最大960 / 1920MBのLLC(Last-Level-Cache)、最大233GBのHBM2e DRAM容量、最大6.3TB/sの帯域幅を持つ様々なバリエーションが概説されています。

これらはすべて理論上のものだが、NVIDIAが今議論していることを考えると、GTC 2022での完全な発表の際には、こうした設計のHopperのバリエーションが登場する可能性が高い。

NVIDIA Hopper GH100の「予備的なスペック」:

| NVIDIA Tesla グラフィックスカード | Tesla K40 (PCI-Express) | Tesla M40 (PCI-Express) | Tesla P100 (PCI-Express) | Tesla P100 (SXM2) | Tesla V100 (SXM2) | NVIDIA A100 (SXM4) | NVIDIA H100 (SMX4?) |

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) | GP100 (Pascal) | GV100 (Volta) | GA100 (Ampere) | GH100 (Hopper) |

| 製造プロセス | 28nm | 28nm | 16nm | 16nm | 12nm | 7nm | 5nm |

| トランジスタ数 | 7.1 Billion | 8 Billion | 15.3 Billion | 15.3 Billion | 21.1 Billion | 54.2 Billion | TBD |

| GPUダイサイズ | 551 mm2 | 601 mm2 | 610 mm2 | 610 mm2 | 815mm2 | 826mm2 | ~1000mm2? |

| SM数 | 15 | 24 | 56 | 56 | 80 | 108 | 134 (Per Module) |

| TPC数 | 15 | 24 | 28 | 28 | 40 | 54 | TBD |

| SM辺りのFP32 CUDA コア数 | 192 | 128 | 64 | 64 | 64 | 64 | 64? |

| SM辺りのFP64 CUDA コア数 | 64 | 4 | 32 | 32 | 32 | 32 | 32? |

| FP32 CUDA コア数 | 2880 | 3072 | 3584 | 3584 | 5120 | 6912 | 8576 ( Module毎) 17152 (Complete) |

| FP64 CUDA コア数 | 960 | 96 | 1792 | 1792 | 2560 | 3456 | 4288 ( Module毎)? 8576 (Complete)? |

| Tensorコア数 | N/A | N/A | N/A | N/A | 640 | 432 | 不明 |

| テクスチャ ユニット数 | 240 | 192 | 224 | 224 | 320 | 432 | 不明 |

| ブーストクロック | 875 MHz | 1114 MHz | 1329MHz | 1480 MHz | 1530 MHz | 1410 MHz | ~1400 MHz |

| TOPs (DNN/AI) | N/A | N/A | N/A | N/A | 125 TOPs | 1248 TOPs 2496 TOPs with Sparsity | 不明 |

| FP16 演算性能 | N/A | N/A | 18.7 TFLOPs | 21.2 TFLOPs | 30.4 TFLOPs | 312 TFLOPs 624 TFLOPs with Sparsity | 779 TFLOPs (Per Module)? 1558 TFLOPs with Sparsity (Per Module)? |

| FP32 演算性能 | 5.04 TFLOPs | 6.8 TFLOPs | 10.0 TFLOPs | 10.6 TFLOPs | 15.7 TFLOPs | 19.4 TFLOPs 156 TFLOPs With Sparsity | 24.2 TFLOPs (Per Module)? 193.6 TFLOPs With Sparsity? |

| FP64演算性能 | 1.68 TFLOPs | 0.2 TFLOPs | 4.7 TFLOPs | 5.30 TFLOPs | 7.80 TFLOPs | 19.5 TFLOPs (9.7 TFLOPs standard) | 24.2 TFLOPs (Per Module)? (12.1 TFLOPs standard)? |

| メモリ インターフェイス | 384-bit GDDR5 | 384-bit GDDR5 | 4096-bit HBM2 | 4096-bit HBM2 | 4096-bit HBM2 | 6144-bit HBM2e | 6144-bit HBM2e |

| メモリ容量 ・種類 | 12 GB GDDR5 @ 288 GB/s | 24 GB GDDR5 @ 288 GB/s | 16 GB HBM2 @ 732 GB/s 12 GB HBM2 @ 549 GB/s | 16 GB HBM2 @ 732 GB/s | 16 GB HBM2 @ 900 GB/s | 最大 40 GB HBM2 @ 1.6 TB/s 最大80 GB HBM2 @ 1.6 TB/s | 最大100 GB HBM2e @ 3.5 Gbps |

| L2キャッシュ サイズ | 1536 KB | 3072 KB | 4096 KB | 4096 KB | 6144 KB | 40960 KB | 81920 KB |

| TDP | 235W | 250W | 250W | 300W | 300W | 400W | ~450-500W |

解説:

さて、nVidiaのサーバー用GPUのHopperくんのリークが入ってきました。

HopperはMCMと言われていますが、1Tile当たりのダイサイズがなんと1000mm2を超えるとのこと。

ちょっと俄かには信じがたい話です。

ここまで大きくするならば、500mm2程度にして4Tileにした方が良いのでは?と思います。

分割するとまあいろいろと問題も出てくるのでしょうが、そもそもMCMにするのは生産性やコスト的な問題のためだと思いますので、1000mm2のダイと言うのは現実味が無いように聞こえます。

リーカーのGraymon55氏はHopperはMCMにならないと言っており、ダイサイスが1000mm2になるならばなかなか説得力がある話です。

コイツをRadeonに対抗するためにGeforceとして投入するという話があります。

サーバー用GPUをDirectX用として出しても大した性能にならないのではないかとか、100万円以上になってしまうのではないかとかいろいろ感じるところはありますが、こちらも続報が出てみないことにははっきりしないところでしょう。

18000近いCUDAコアをゲームでブン回すところは見てみたい気もしますが・・・・。

nVidia RTX4000SUPER

nVidia RTX4000

nVidia RTX3000シリーズGPU

RTX3060 12GB GDDR6

RTX3050 6GB