生産高が3倍になれば、収入も3倍になるのか?

データセンター向けコンピュートGPUで1四半期に100億ドル以上を稼いだばかりのNvidiaは、2024年にはそのような製品の生産量を少なくとも3倍にする計画だと、この件に詳しい情報筋の話を引用したFinancial Timesが伝えている。

この動きは非常に野心的なもので、もしNvidiaがこれを成功させ、人工知能(AI)やハイパフォーマンス・コンピューティング(HPC)アプリケーション向けのA100、H100、その他のコンピュートCPUの需要が好調を維持すれば、これは同社にとって信じられないほどの収益を意味する。

エヌビディアのフラッグシップGPUであるH100の需要は非常に高く、2024年まで完売が続くとFT紙は報じている。

同社はGH100プロセッサーの生産を少なくとも3倍に増やすつもりだと、同ビジネスサイトはNvidiaの計画に詳しい3人の人物の話を引用して主張している。

2024年のH100の出荷台数は150万台から200万台と予想されており、今年予想されている50万台から大幅に増加することになる。

NvidiaのCUDAフレームワークはAIやHPCワークロード向けに調整されているため、NvidiaのコンピュートGPUでしか動作しないアプリケーションは何百と存在する。

アマゾン・ウェブ・サービスとグーグルの両社は、AIのトレーニングや推論ワークロード用に独自のカスタムAIプロセッサーを持っているが、クライアントがNvidiaのコンピュートGPUでアプリケーションを実行することを望むため、NvidiaのコンピュートGPUを大量に購入しなければならない。

しかし、Nvidia H100コンピュートGPU、GH200 Grace Hopperスーパーコンピューティング・プラットフォーム、そしてそれらをベースとした製品の供給を増やすことは容易ではない。

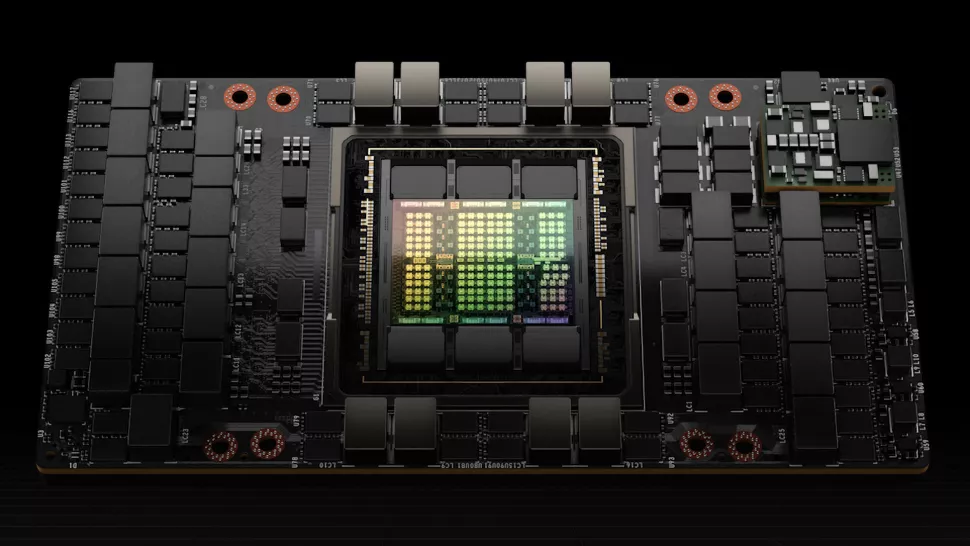

NvidiaのGH100は複雑なプロセッサーで、製造はかなり難しい。

その出力を3倍にするためには、いくつかのボトルネックを取り除かなければならない。

まず、GH100コンピュートGPUは814mm^2の巨大なシリコンであるため、大量生産はかなり難しい。

現在、同製品の歩留まりはそれなりに高いと思われるが、NvidiaがGH100ベースの製品の生産量を3倍にするには、TSMCから大量の4Nウェハ供給を確保する必要がある。

大まかな見積もりでは、TSMCとNvidiaは300mmウェハーあたり最大65個のチップを得ることができる。

このようなチップを200万個製造するためには、約3万1,000枚のウェハーが必要となる。

確かに可能ではあるが、TSMCの5nmクラスウェハーの総生産量(月産約15万枚)のごく一部である。

この生産能力は現在、AMD CPU/GPU、アップル、Nvidia、その他の企業で共有されている。

第2に、GH100はHBM2EまたはHBM3メモリに依存し、TSMCのCoWoSパッケージを使用するため、Nvidiaはこの面でも供給を確保する必要がある。

現在、TSMCはCoWoSパッケージの需要を満たすのに苦労している。

第3に、H100ベースのデバイスはHBM2E、HBM3、またはHBM3Eメモリを使用するため、Nvidiaはマイクロン、サムスン、SKハイニックスなどの企業から十分なHBMメモリパッケージを調達する必要がある。

最後に、NvidiaのH100コンピュートカードやSXMモジュールはどこかにインストールされなければならないため、

NvidiaはパートナーもAIサーバーの出力を少なくとも3倍にする必要があり、これも懸念事項だ。

しかし、もしNvidiaが必要なH100 GPUをすべて供給することができれば、Nvidiaは来年、この取り組みで巨額の利益を上げることができるだろう。

ソース:Tom's - Hardware - Nvidia to Reportedly Triple Output of Compute GPUs in 2024: Up to 2 Million H100s

解説:

nVIDIAは2024年にAI/ML用のGPUの生産を3倍にする。

nVIDIAは我が世の春を歌っているようですね。

私は以前、Ampereの大量在庫によってAda Lovelaceの売り上げにも影響が出ているという話が出たとき、ゲーム用が売れなかったら生産調整してAI/ML用のGPUを作ればよいだけなのでnVIDIAは散っても困ってないと書きましたが、売れなくて困っているどころか売れすぎてどうやって生産するのかに頭を悩ませている状態のようです。(苦笑。

本当に今のAI/MLの(サーバー向け)GPUの人気には驚かされるばかりです。

H100はPCIex版でも500万以上しますが、これが飛ぶように売れているのですから、nVIDIAは笑いが止まらないでしょう。

AMDもMI200とかMI300で後を追っていますが、市場は圧倒的にnVIDIAであり、それ以外の製品は引き合いが無いのでしょうね。

元記事の中でも

私もXでツイートをしましたが、リツイートでいろいろな意見をいただきましたが、AI/ML関連の開発にはnVIDIA GPU+Tensorflowが無いのは考えられないという意見がありました。

アマゾン・ウェブ・サービスとグーグルの両社は、AIのトレーニングや推論ワークロード用に独自のカスタムAIプロセッサーを持っているが、クライアントがNvidiaのコンピュートGPUでアプリケーションを実行することを望むため、NvidiaのコンピュートGPUを大量に購入しなければならない。

このようにあります。

幾ら自前で優秀なAI/MLチップを用意しても開発/実行環境も含めたソフト資産をたっぷり持っているnVIDIAには敵わないということなのでしょう。

他社が手を付けていなかった時期から投資を始めていたnVIDIAに今から追いつくのは並大抵の努力では無理でしょう。

ゲーム用のGPUは余っているがAI/ML向けは足りないのでnVIDIAはちっとも困っていないという私の予想はこれで確定ですね。

今のnVIDIAのAI/ML関連の勢いは「神の見えざる手」すらも蹴り飛ばし、市場を支配しているということです。

nVidia RTX4000SUPER

nVidia RTX4000

nVidia RTX3000シリーズGPU

RTX3060 12GB GDDR6

RTX3050 6GB