Geforce RTX 2080/TiはFP32の演算性能では旧モデルと比較すると1-2TFlops程度しか性能が向上していません。

新技術のRTXのみに目が行きがちになりますが、どうも他にも目玉があるようです。

DLSS(Deep Learnig Super Sampling)という機能をオンにすると一部のサポートされているゲームで性能が向上するようです。

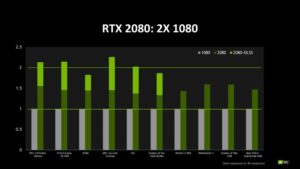

上はnVidiaが公式で出したその比較表です(クリックで別窓で拡大します。)

DX11のゲーミング性能というのはほぼFP32の性能に比例しています。

GTX1080TiやTitanVくらいになるとFP64やTensorコアなどの演算性能を含めてメモリ帯域が設定されている物と思います。

| GTX1080 | GTX1080Ti | TitanV | RTX2080 | RTX2080Ti | |

| アーキテクチャ | Pascal | Pascal | Volta | Turing | Turnig |

| CUDAコア数 | 2560 | 3584 | 5120 | 2944 | 4352 |

| FP32演算性能(TFLOPS) | 9 | 11.34 | 13.8 | 10.1 | 13.4 |

| メモリ帯域幅(GB/sec) | 320 | 484 | 653 | 448 | 616 |

| FireStrikeスコア | 21830 | 27810 | 33441 | 不明 | 不明 |

| GTX1080比:FSスコア | 1 | 1.27 | 1.531 | 不明 | 不明 |

| GTX1080比:FP32 | 1 | 1.26 | 1.533 | 1.122 | 1.467 |

| GTX1080比:メモリ帯域幅 | 1 | 1.513 | 2.04 | 1.4 | 1.925 |

上がその状況を比較したものです。

比較しているのがFireStrikeのスコアのみ(DX11の性能)ですのでこの現象が問題の本質を表しているのかどうかまでは断言できません。

この「TitinVで思ったほど性能が向上していない現象」は実は私もずっと気になっていました。

※ もっと言えばGTX1080とGTX1080Ti間でもメモリ転送速度に対してリニアに性能が向上してません。

コスパという言葉が好きな人がいるので書いておきますが、TitanVはゲーム用としては極めてコスパの悪いGPUと言えると思います。(最もTitanVはゲーム向けとして出されているものではありませんが。)

上の表を見ると、メモリ帯域幅から推測するとそれなりのウェイトをしめてきているTensorコアやFP64のユニットを有効活用する必要性みたいなものがあったことが理解できます。

性能には主に質を向上させる(変化させる)ものと速度を変化させるもの(量的な変化)の2種類ありますが、RTXは明らかに前者(純粋な演算性能という点では後者かもしれませんが、ゲームに反映されるのは明らかに前者)なので直接の性能向上がわかりにくいです。

RTXをオンにしたShadow of ToomRaiderの動画も公開されていますが、比較してみないとわかりにくいです。

nVidiaはRTX2000シリーズを「ここ10年で最大の進化」とぶち上げて大きな価格向上を正当化していますが、海外の一部テクニカルライターは「思ったほど性能が上がってない」と反発しているようです。

GTX1080とRTX2080を従来通りのゲーミング性能(FP32)で測ると1割ちょっとしか性能が向上していないので当然と言えば当然です。

この辺はCPUに拡張命令を搭載しないとシングルスレッド性能が向上しなくなってしまったのと同じ傾向なのかもしれませんが、RTXやDLSSが具体的にどのような仕組みで作用するものなのかをnVidiaが解説しない限りは何とも言えませんね。

とにかく、Geforce RTX 2000シリーズから、全体の演算性能を向上させるというよりは特定の方向性を打ち出してそれを利用して性能を向上させるという方向にシフトさせてきたことは確かのようです。

これを最大の変化と言っているようですが、具体的にどうしてそうする必要性があったのかということはもっと解説してほしいところです。

同時にGeforce RTX 2000シリーズの新機能にソフト側で対応しない限りはその恩恵を完全に受けることは出来ないということがはっきりしてきました。

上の表から推測すると全く新技術に対応していない旧作ゲームの性能向上率(=FP32の演算性能)はGTX1080比でRTX2080で1.122倍、RTX2080Tiで1.467倍です。

これが多分RTX2000シリーズの特性であり、nVidiaが最もアピールしなくてはならないことでしょう。

RTコアがどの辺に実装されて、どのくらいトランジスタを割いているのかも解説されていない(解説はされているのかもしれませんが少なくとも現時点ではどこも記事にしていない)ので、この辺は情報が降りてくるのを待つしかありません。(降りてこない可能性もありますが。)

この辺をもっとわかりやすく解説しないと消費者からの理解は得られないんじゃないかと個人的には思っています。

RTXやDLSSが具体的に何をしている物で、何故必要なのかということをもっとアピールしてほしいところだと思います。

一般の人よりも知識のあるテクニカルライターですらもよくわからずにnVidiaに質問をぶつけているレベルですから、一般の人は何をいわんやです。

RTXとDLSSの対応表

| タイトル | RTX | DLSS |

| Ark: Survival Evolved | No | Yes |

| Assetto Corsa Competizione | Yes | No |

| Atomic Heart | Yes | |

| Battlefield V | Yes | No |

| Control | Yes | No |

| Dauntless | No | Yes |

| Enlisted | Yes | No |

| Final Fantasy XV | No | Yes |

| Fractured Lands | No | Yes |

| Hitman 2 | No | Yes |

| Islands of Nyne | No | Yes |

| Justice | Yes | |

| JX3 | Yes | |

| MechWarrior 5: Mercenaries | Yes | |

| Metro Exodus | Yes | No |

| PlayerUnknown’s Battlegrounds | No | Yes |

| ProjectDH | Yes | No |

| Remnant: From the Ashes | No | Yes |

| Serious Sam 4: Planet Badass | No | Yes |

| Shadow of the Tomb Raider | Yes | No |

| The Forge Arena | No | Yes |

| We Happy Few | No | Yes |

推測ですが、DLSSというのは名前を見るとゲームに搭載されているAIの速度を加速させるような印象がありますが、Tensorコアを活用するかしないかを表しているようですね。

現時点でおそらくあまり周知されてないと思いますので、エンドユーザーの周知のために早めに対応が必要なのかなと思います。

※ TensorコアというのはVoltaから搭載されるようになったディープラーニング用の新設計コアでFP32演算においてFP32コアに換算すると1.5倍程度の性能を持つと言われています。あくまでも換算するとですので、その点は注意。上の表を見てもわかる通り、ソフト側での対応が必要のようです。

videocardz - NVIDIA publishes GeForce RTX 2080 vs GeForce GTX 1080 comparison

※ 追記

通常のAA(アンチエリアシング)のモードで、おおむね1.5倍程度というスコアが出ている。

加えて、今回のGeForce RTX 20シリーズから導入されたTensorコア使ったAIノイズ削減などを行なう「DLSS」(Deep Learning Super-Sampling)を利用する場合、その性能は2倍を超えるとNVIDIAでは説明している。

やはりDLSSというのはTensorコアを使った処理のようです。

「アンチエリアシングにてTensorコアを使いAIノイズ削減を行うモード」のようです。この処理に対応しているゲームはGTX1080比約二倍の速度が出るということのようです。

nVidiaはFP32演算を行うコア(CUDAコア)を増やして性能競争を行う時代はもう終わったということが言いたかったようですね。

今までの例からすると主にFP32の性能しか見ませんので、nVidiaの真意をくみ取れなかったということのようです。

それが恐らくRTXにブランドを変更したもう一つの意味だったのだと思います。

nVidiaは第二四半期の決算報告ででRadeonに勝利宣言ともとれる発言をしていますが、最新のゲームではないFF15がDLSSに対応しているところを見ると、nVidiaの提供する開発環境を使っている製品はかなり前からこのDLSSに対応しているようです。

ソフト会社に対する根回し的な部分で「勝負あった」ということなのでしょう。

これに対するAMDの対応というのはかなり気になるところです。

ソース:PCWatch - GeForce RTX 2080はGTX 1080比で1.5~2倍のゲーム性能。NVIDIAが情報を公開

※ 更に追記

PC Gamerの記事によると、TAA(従来のアンチエリアシング手法)を切っても5-10%しか性能が改善することはない。

DLSSは4KやHDRで設定を一番高品質にしたときにパフォーマンスが改善する技術ではないかと推測し、その話をうのみにすることは出来ないが、現物が届いた時点でテストをしたいという風に説明しています。

この話(nVidiaの説明)を信じるとするとRTX2080でもGTX1080Tiを上回り、RTX2070でもGTX1080Tiの性能を超えるかもしれないと書いています。

海外のメディアは基本的にnVidiaの説明には懐疑的ですが、「Pascalからほんのちょっとしか性能が改善されてないと判断するのは早すぎるかもしれない」というようなことも書いています。

9月に入って現物が届くまでは判断を保留したいというのが本音のようです。

今のGPUは全般的にFullHDの60Hzでは既にミドルレンジのGPUと性能差が付かなくなっていますので、4KやHDR状態での性能を改善するというのは正しいアプローチだと思います。

DLSSにしてもRTXにしてもCUDAコアを単純に増やしていって全体の性能を向上させるものではなく、レイトレーシングとかアンチエリアシングとかいった処理の重い部分にピンポイントに適用する技術なのは面白いところです。

AI処理に関する技術(Tensorコア)に関してはnVidiaが頭一つ抜けていると言われていますので、これを有効に活用しようとするのは非常に正しいと思いますし、TuringにTensorコアを搭載してきた主な理由なんでしょうね。

「実際に見てみないと判断できない」というのが海外のメディアの今のところの見解のようです。

nVidiaの大本営発表はとりあえず聞いておくけど、あとは現物を手に入れて自分でテストしてみるよという感じでしょうか。(笑

大手のメディアが「なんかちょっと納得できない」とはっきり言う、このメーカーとメディアとの距離感みたいなものは面白いですね

うちのサイトもテスト機を第9世代9900Kの発売に合わせてそろえるかどうか迷ってるところですが、Geforce RTX 2000シリーズの話を聞くと欲しくなってきました(笑

※ 補足すると、検証するのにも4KのHDRモニタが無いと差がわからないかもしれないということですね。いよいよ本格的な4K時代に入ったということでしょうか。

ソース:PC Gamer - Nvidia's benchmarks claim the RTX 2080 will be 50% faster than GTX 1080