データセンター向けチップのCobaltとMaiaはTSMCで製造される。

マイクロソフトのAIファーストの取り組みは、カスタムチップにまで及んでいる。マイクロソフトは、パートナー開発者向けカンファレンス「Microsoft Ignite」で、ワシントン州レッドモンのシリコンラボで設計された2つのカスタムチップ「Azure Maia 100 AIアクセラレータ」と「Azure Cobalt 100 CPU」を発表した。

マイクロソフトがTom's Hardwareに語ったところによると、両チップはTSMCの「最新のプロセスノード」で製造されている。

これらのチップは、マイクロソフトのデータセンターで「来年初め」に登場し、マイクロソフトのCopilot、Azure OpenAI、その他のサービスを稼働させることからスタートする。

何個のチップが利用可能になるのかとの質問に対し、広報担当者は、マイクロソフトはデータセンターで「初期サーバー」をオンラインにして「展開の第一段階」にあると述べるにとどめた。

同社は今後も、NvidiaやAMDといったパートナーのチップを使用する顧客にサービスを提供する予定だ。

マイクロソフトはスペックの詳細をあまり公表していないため、新しい製品をNvidiaやAMDのオプションと比較するのは難しい。

マイクロソフトはTom's Hardwareに対し、Maia 100は5ナノメートル・プロセスで製造され、1,050億トランジスタを誇り、"現在の技術で製造可能なチップの中で最大級のものである "と述べた。

「Maiaのサーバーは、アクセラレーターあたり4.8テラビットの総帯域幅を持つ完全にカスタム化されたイーサネット・ベースのネットワーク・プロトコルで設計されており、より優れたスケーリングとエンド・ツー・エンドのワークロード性能を可能にする」とマイクロソフトは付け加えた。

わかっているのは、Maia 100 AIアクセラレータ(GPU)は大規模な言語モデル用に設計されているということだ。

マイクロソフトによると、OpenAIはMaia 100の設計について「フィードバックを提供した」という。

「マイクロソフトが初めてMaiaチップの設計を公開したとき、我々は興奮し、我々のモデルでそれを改良しテストするために協力してきました」とOpenAIのCEOサム・アルトマンはマイクロソフトのブログ投稿で述べている。「AzureのエンドツーエンドのAIアーキテクチャは、Maiaによってシリコンまで最適化され、より高性能なモデルをトレーニングする道を開き、そのモデルを我々の顧客にとってより安価なものにする。

Maiaチームを率いるマイクロソフトのテクニカルフェロー、ブライアン・ハリーは、Maia 100はマイクロソフトの既存のインフラ用に特別に作られたもので、"パフォーマンスと効率に大きな利益をもたらすことができる "と述べた。

一方、Cobalt 100 CPUはArmベースで、ハードウェア製品開発担当コーポレート・バイス・プレジデントのWes McCullough氏はブログの投稿で、"電力効率を念頭に置いて設計されている "と述べている。

「マイクロソフトはTom's Hardwareに対し、「Azure Cobaltは、マイクロソフトの目的に合わせてカスタマイズされたARM Neoverse CSSに基づくArmからのライセンス設計を使用している。

「64ビットの128コアチップは、現行世代のAzure Armサーバーに比べて最大40%の性能向上を意味する。

同社はまた、独自のチップを設計することで、データセンターの冷却を強化し、既存の施設のキャパシティを高めることができるとしている。

同社によると、「Maia 100サーバーボードのユニークな要件を収容できる」サーバーラックがなかったため、ラックをゼロから構築する必要があったという。

「マイクロソフトのブログ記事には、「これらのラックは、同社のデータセンターに通常設置されているものよりも幅が広い。

この拡張設計は、AIワークロードのユニークな要求に不可欠な電源とネットワークケーブルのための十分なスペースを提供します。」

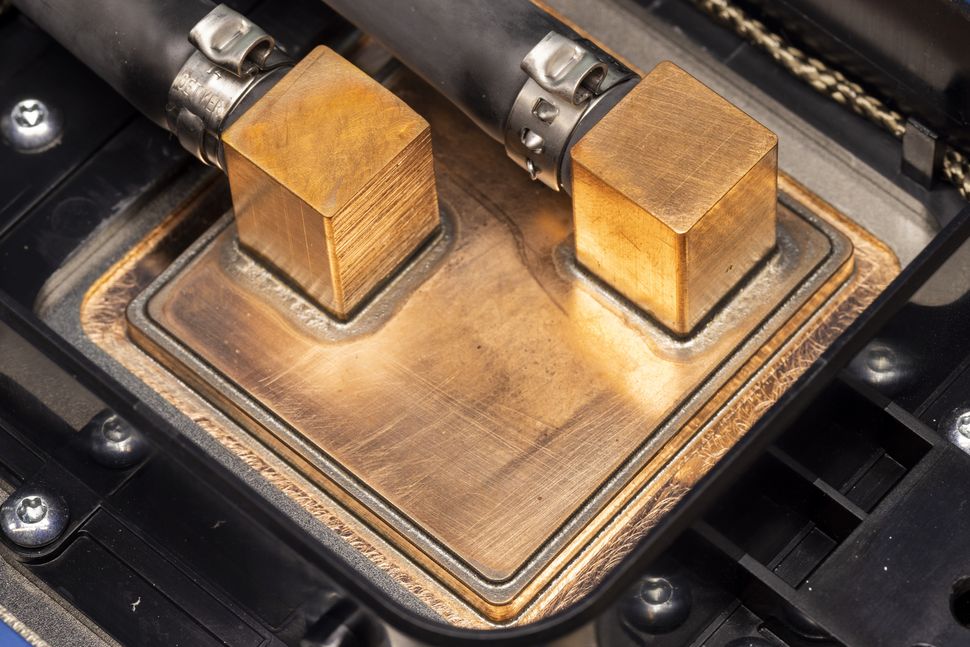

同社はまた、複雑なAI作業中にこれらのチップを冷却するための液体冷却ソリューションを考え出す必要があったが、"大型液体冷却装置 "を設置するためのデータセンターを持っていなかった。

そこでマイクロソフトは、Maia 100サーバーのラックの隣に座り、Maia 100チップに取り付けられたコールドプレートに冷たい液体を送り、温かい液体をサイドキックに戻して熱を取り除き、再びラックに液体を戻すことができる「サイドキック」と呼ぶものを使用している。

マイクロソフトは、カスタムラックと冷却設計を業界パートナーと共有しているという。

「マイクロソフトのAzure Hardware Systems and Infrastructureチームのパートナープログラムマネージャーであるパット・ステーメンは、「インフラ、ソフトウェア、ファームウェアに関わらず、我々が構築したものはすべて、我々のチップを導入しようが、業界パートナーのチップを導入しようが、活用することができる。

「これは顧客が選択することであり、パフォーマンスやコストなど、顧客が気にする次元に関わらず、顧客にとって最良の選択肢を提供しようとしている。

同社はすでに、Maia AIアクセラレータとAzure Cobalt CPUの第2世代バージョンの開発に取り組んでいる。

新しいハードウェアに加え、マイクロソフトはAzure Boostも発表した。Azure Boostは、ストレージとネットワーキングのプロセスをホストサーバーから、これらの目的専用に設計されたハードウェアとソフトウェアに移行することで、より迅速な処理が可能になるとしている。

マイクロソフトはまた、AMDとNvidiaの両社とのさらなる提携も発表した。チームレッド側では、マイクロソフトはAzureプラットフォームにAMD MI300X仮想マシンを追加する。

Ndvidiaについては、NvidiaのH00 Tensor Core GPU向けに設計された新しいNC H100 v5仮想マシン・シリーズのプレビューがある。

この記事を書いた時点では、MaiaとCobaltに関する多くの詳細は明らかになっていない。

しかし、我々はマイクロソフトに更なる質問をぶつけているので、近々ここでもっと報道されることを期待している。Meta、オラクル、グーグルなど、クラウドに特化した特注のデータセンター向けCPUがひしめく中、マイクロソフトのこの動きは大きなインパクトを与えそうだ。

Intel、AMD、Nvidiaのような古くからのデータセンターの主力企業はもちろん、Ampereのような比較的に新しい企業も、これらの発表の影響を受け、独自の大胆な動きをしなければならないだろう。

解説:

マイクロソフトがサーバー向けARMチップを内製

通常のサーバー用ではなく、AI機能向けのようです。

クラウド企業がなぜ自社製CPUに力を入れているのかと言うと、nVIDIAの製品は欲しくても買えないという調達に問題が発生していることとコストの問題ですね。

MSの直近のクラウド投資額は1.5兆円です。

も既に億で無くて兆単位になっています。

それでもAIのサーバーはまだまだ足りない状態だそうです。

ここまで金額が大きくなると他社製品の場合、調達数を大きくするのも大変ですし、需要が大きい分野ですからコストもバカにならないです。

じゃあどうするかと言うとamzonやGoogleも含めて「自社で設計・製造しよう」という結論になるわけです。

今はAIの需要が高くなっていますから、どこの企業も一斉にAIサーバーの調達に走るわけですが、買えなかったら「出来ませんでした」ではその分ライバル企業との差が開いてしまいます。

nVIDIA製品を調達する分は確保して自社製品も投入していくわけです。

それでもAIサーバーの数が足りてないわけですから、どれだけ加熱しているのかがよくわかりますね。

nVIDIAはH100、AMDMI300Xこれらのチップを調達した上で自社の製品も調達しているわけで、今後も当面、AI向けサービスや機能がPCのトレンドになることは確実です。

マイクロソフトと言えばソフトウェアを作っている企業と言うイメージがありますが、近年は完全にクラウドサービス中心になっています。

こういったところにも時代を感じます。