AIがMeteor Lakeで大活躍

Computex 2023に向け、インテルは同社の新チップ「Meteor Lake」でデビューするAIに特化した新VPUシリコンに関する新たな詳細を発表しました。

また、同社は、今後のMeteor LakeチップのAIエコシステムを実現するための取り組みについても概説しました。

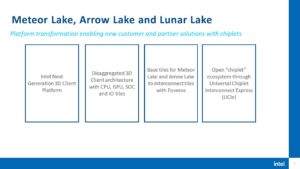

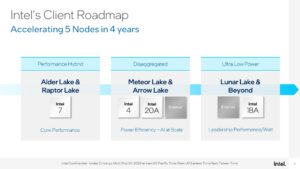

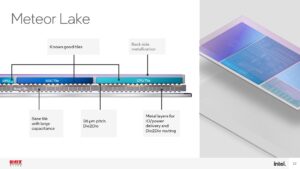

インテルは、インテルとTSMCの両方の技術を1つのパッケージで活用するブレンドチップレットベースの設計を採用した初のMeteor Lakeプロセッサーを年内にリリースする予定です。

このチップは、電力効率とローカルAIワークロードのパフォーマンスに重点を置いて、まずノートパソコンに搭載される予定ですが、この設計の異なるバージョンはデスクトップPCにも搭載される予定です。

AppleとAMDの両社は、シリコンに組み込まれた強力なAIアクセラレーション・エンジンですでに前進しており、Microsoftも、カスタムAIアクセラレーション・エンジンを活用する新しい機能を備えたWindowsの開発に余念がない。

先週、Intel、AMD、MicrosoftがPCにAIを搭載する時代が来ると発表したのに続き、Intelはコンシューマー向けPCチップに独自のカスタムアクセラレーションブロックを搭載し、新たなクラスのAIワークロードにどう対処するかについて深く掘り下げています。

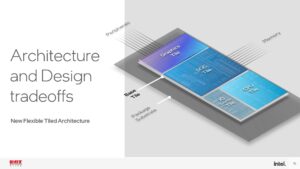

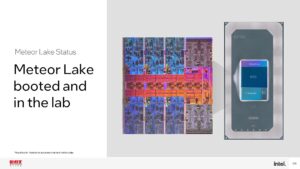

IntelはMeteor Lakeチップのいくつかの新しいレンダリングを共有し、我々はすでにHot Chips 2022の間に全体のハードウェア設計をカバーしました。

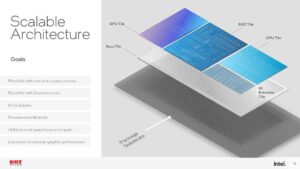

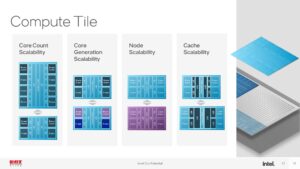

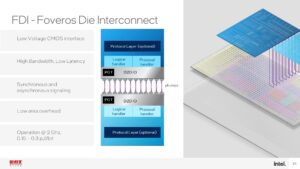

これらのチップは、Intel 4プロセスノードと、GPUやSoCタイルのような他の機能のためのN5およびN6プロセスのTSMCファブドチップレットのスレッドを活用する最初のものとなります。

ここでは、チップが4つのユニットに分割され、CPU、GPU、SoC/VPU、I/Oタイルが、インテルの3D Foverosパッケージング技術によるインターポーザの上に垂直に積み重ねられていることがわかります。

また、記事の最後には、Hot Chipsカンファレンスで発表された、より詳細なアーキテクチャの詳細を記した別のスライドデッキを掲載した。

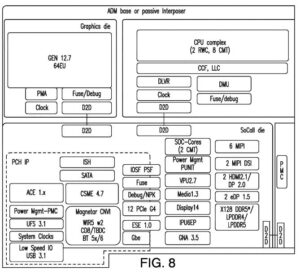

ここで注目されるのはVPUユニットですが、最初の画像はIntelが今日の発表のために公開した簡略化した図ですが、誤解しないでください--このタイル全体がVPU専用というわけではありません。

その代わり、I/O、VPU、GNAコア、メモリコントローラなど、さまざまな他の機能を持つSoCタイルとなっている。

このタイルはTSMCのN6プロセスでファブされているが、IntelのSoCアーキテクチャとVPUコアが搭載されている。

VPUがこのダイエリア全体を消費していないのは良いことで、そうするとIntelはダイエリアの30%近くを、少なくとも最初のうちはあまり使われないであろうユニットに使っていることになる。

しかし、後述するように、VPUコアをフル活用するために必要なアプリケーションエコシステムを開発者が実現するまでには、ある程度の時間がかかるだろう。

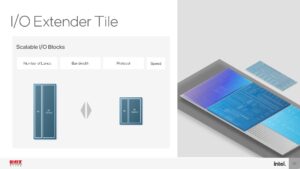

上のアルバムでは、IntelのHot Chipsプレゼンテーションから、I/Oダイ上の機能を同社が公式にグラフ化した画像を掲載した。

また、「fig.8」と書かれたスライドも入れた。このブロック図は、Meteor Lakeの設計の概要を示すと広く考えられているIntelの特許に由来するもので、このチップについてすでに分かっていることと概ね一致しています。

Intelは、図のSoCタイルに「GNA 3.5」と記された、同社のチップにすでに存在する低消費電力AIアクセラレーションブロック「Gaussian Neural Acceleration」を引き続き搭載する(これについては以下で詳しく説明します)。

また、新しいMovidiusベースのVPUブロックを構成する「VPU 2.7」ブロックも見て取れます。

Intelの様式化されたレンダリングと同様に、この特許画像も、実際のダイの物理的なサイズと相関関係のない単なるグラフィカルなレンダリングである。

メディアやディスプレイエンジン、電源管理はもちろん、メモリコントローラ、PCIe、USB、SATAなど、非常に多くの外部インターフェイスがあるため、VPUコアがSoCタイルのダイ面積をあまり消費できないことは容易に理解できる。

今のところ、Intelがこのエンジンにどれだけのダイ面積を割いているかは不明である。

| Intel Meteor Lake タイル/チップレット | 製造者/ 製造ノード |

| CPUタイル | Intel / 'Intel 4' |

| 3D Foveros ベースダイ | Intel / 22FFL (Intel 16) |

| GPU タイル (tGPU) | TSMC / N5 (5nm) |

| SoCタイル | TSMC / N6 (6nm) |

| IOEタイル | TSMC / N6 (6nm) |

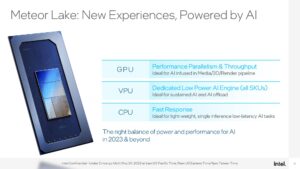

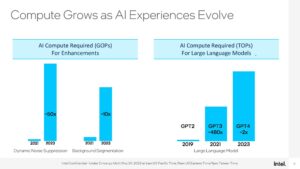

VPUは持続的なAIワークロードのために設計されているが、Meteor LakeにはCPU、GPU、GNAエンジンも含まれており、様々なAIワークロードを実行することができる。

IntelのIntelによると、VPUは主にバックグラウンドタスク用で、より重い並列化された作業にはGPUが介入する。

一方、CPUは軽い低レイテンシの推論作業に対応する。一部のAIワークロードはVPUとGPUの両方で同時に実行することもでき、インテルは、開発者が手元のアプリケーションのニーズに基づいて異なるコンピュートレイヤーをターゲットにできるメカニズムを実現しました。

これは最終的に、より低い消費電力でより高いパフォーマンスを実現する--AIアクセラレーションVPUを使用する際の重要な目標である。

Intelのチップは現在、オーディオやビデオ処理機能の低消費電力AI推論にGNAブロックを使用しており、GNAユニットはMeteor Lakeに残ります。

しかし、IntelはすでにGNAに特化したコードの一部をVPU上で実行し、より良い結果を得ているとし、将来のチップで完全にVPUに移行し、GNAエンジンを削除するという重い意味合いを持たせています。

また、IntelはMeteor Lakeが、ユニファイドメモリサブシステムを実現するコヒーレントファブリックを備えており、コンピュートエレメント間でデータを容易に共有できることを意味していることを明らかにした。

これは、AppleのMシリーズやAMDのRyzen 7040チップなど、CPUのAI分野における他の競合とコンセプトが似ている重要な機能である。

ここでは、Intelのスライドウェアを紹介し、AIで加速するアプリケーションをPCに導入するための膨大なソフトウェアとオペレーティングシステムのエコシステムを実現するためのIntelの取り組みを紹介しています。

Intelは、AIを主流にするための市場プレゼンスと規模を有しており、x86ハイブリッドAlderおよびRaptor LakeプロセッサのサポートをWindows、Linux、および広範なISVエコシステムにもたらした協業活動を指摘しています。

最新のオペレーティングシステムやアプリケーションにAIアクセラレーションを導入する上で、業界は同様の課題に直面するでしょう。

しかし、AIワークロードをローカルで実行する機能があっても、独自の難しい実装のために開発者がその機能をサポートしないのであれば、あまり意味がありません。

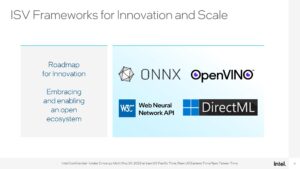

ローカルのAIワークロードを簡単にサポートするための鍵は、MicrosoftとAMDが提唱する機械学習用のDirectML DirectX 12アクセラレーション・ライブラリです。

IntelのVPUはDirectMLだけでなく、ONNXとOpenVINOもサポートしており、Intelは自社のシリコンでより良いパフォーマンスを提供するとしています。

しかし、ONNXとOpenVINOは、最大限の性能を引き出すために、ソフトウェア開発者がよりターゲットを絞った開発作業を行う必要があります。

ChatGPTのような大規模な言語モデルなど、今日のより激しいAIワークロードの多くは、データセンターで実行され続ける強烈な計算能力を必要とします。

しかし、インテルは、コストを上乗せすることはもちろん、レイテンシーやプライバシーに関する懸念があると主張しています。

オーディオ、ビデオ、画像処理のような一部のAIアプリケーションは、PC上でローカルに対処できるようになり、Intelは、レイテンシ、プライバシー、コストを改善することができると述べています。

Intelは、リアルタイムでのビデオやオーディオ処理、Unreal Engineのリアルタイムモーションキャプチャなど、ローカルAIアクセラレーションの恩恵を受けられるさまざまなワークロードを指摘している。

また、IntelはMeteor LakeのGPUとVPUで同時に動作するStable Diffusionと、VPUのみで動作する超解像のデモを行なった。

しかし、このデモではパフォーマンスの観点からの参照枠がないため、他のソリューションと比較した相対的なパフォーマンスを証明することはできません。

さらに、すべての安定拡散モデルがプロセッサ上でローカルに動作するわけではなく、個別のGPUアクセラレーションが必要です。

現在、一般的なアプリケーションの多くが、何らかの形でローカルAIアクセラレーションをサポートしていますが、その選択肢はまだかなり限られています。

しかし、インテルと業界全体による継続的な開発作業により、AIアクセラレーションは時間の経過とともに一般的になっていくでしょう。

Hot Chipsのプレゼンテーションから、よりアーキテクチャの詳細がわかるスライドを紹介する。

Intelによると、Meteor Lakeは今年中にリリースされる予定だが、まずはノートPCに搭載されるとのこと。

現在のところ、Meteor LakeのデスクトップPC用チップは、保守的な35Wと65Wのパワーエンベロープで評価される比較的低価格のCore i3とCore i5モデルに限定されることをすべての兆候が示しているが、Intelはまだ正式な発表をしていない。

今年末の発売が近づくにつれ、より多くの情報が得られると思われます。

ソース:Tom's Hardware - Intel Demos Meteor Lake's AI Acceleration for PCs, Details VPU Unit

解説:

VPUやAIEがなぜ必要なのか私にもようやく理解出来ました。

最近、ROCm 5.5に対応したPytorch2.0.1のバイナリをビルドしたからなのか、肌感覚として、今なぜCPUの中にAIアクセラレーターが必要なのか理解出来ました。

OpenAIのCEO、「巨大AIモデルを用いる時代は終った」と語る

AI関連で最先端を走るOpenAIのCEOもクラウドの高速なコンピューター上で実行してそこにクライアントでアクセスするタイプの「大規模モデル」はもう限界であると発言しており、これからはクライアントにAIのアクセラレーターが搭載され、ローカルでプログラムが実行される時代が来るということです。

AIがどれくらい世の中を変えていくかは実際にStable Diffusion WebUIやAutoGPTなどのローカルで実行するプログラムを使ってみないとわからないので、ゲーマーの方もどちらか、あるいは両方を使ってみることをお勧めします。

私はマンガやアニメ・ゲームに親しんできたのでイラストAIであるStable Diffusion WebUIを選びましたが、AutoGPTでも全然OKです。

AutoGPTもStable Diffusion WebUIでのいくつかのやり残しが終わったら多やってみるつもりです。

あと1年ほどで我々はRTX5000シリーズを手に入れて、「nVidia史上最大」と言うGPUパワー(=AIアクセラレーション)を手に入れます。

そうなると、個人レベルで大規模モデルに近いAIプログラムをローカルで実行できるようになるかもしれません。

Windows11にもWindowsCopilotと言うAIプログラムが実装される予定ですから、AIが一般人が手軽に使える世界と言うのはすぐそこまで来ているということになります。

やりたいことはAIに聞けばよいのでWindowsのTIPSサイトなどはもう必要なくなるかもしれませんね。

今我々は歴史の重要な分岐点に立っているのかもしれません。

AMDはPhoenix Pointで既にAIEを実装したのでAI関連では珍しくIntelより先行しているということになりますね。

Core Ultra 200Sシリーズ

ソケットLGA1851

Intel 第14世代Coreシリーズ

ソケットLGA1700

※ 末尾にFがついているモデルはGPUがありませんのでご注意ください。