NVDIDIAのBlackwell Ultra「B300」GPUは、GB300サーバーにソケット式デザインを導入する可能性があり、メンテナンスやアップグレードが容易になる。

ソケットベースの設計により、NVDIDIAのAI GPU「Blackwell Ultra 「B300」」はCPUと同じように利用できる可能性がある。

エヌビディアの現在のデータセンター向け高性能チップは、オンボードソリューションであるOAM設計を採用している。

この設計では、GPUチップはGB200のようなサーバーのマザーボードに恒久的にはんだ付けされ、ユーザーはGrace CPUとBlackwell GPUの両方を1枚のボード上で見つけることができる。

※ 画像をクリックすると、別Window・タブで拡大します。

しかし、NVIDIAがGB300サーバー向けのBlackwell B300「Ultra」GPUで異なる設計に移行する可能性を示唆する複数の報道があるため、これがオンボード設計を特徴とする最後のシリーズになる可能性がある。

MoneyDJとEconomic Daily News(Trendforceより)によると、B300 GPUはソケットベースの設計を採用する可能性があり、これによりユーザーはマザーボードからGPUをインストールまたはアンインストールできるようになる。

NVIDIAのBlackwell Ultra「B300」AI GPUのソケット式アプローチは、NVIDIAの製造プロセスを簡素化し、複数の企業、特に相互接続部品とソケットを製造する台湾のFoxconnとLOTESに利益をもたらすと言われている。

現在のBlackwell GPUはマザーボードに直接はんだ付けされており、ソケットタイプに移行することで、B300 GPUはCPUのようにマザーボードから取り外すことができる。

この移行により、GPUをソケットにはんだ付けする必要がなくなり、エヌビディアは表面実装技術に頼る必要がなくなるため、歩留まり率の向上や柔軟な生産など、いくつかの利点がある。

さらに、GPU関連の問題が発生した場合にマザーボード全体を交換する必要がなくなるため、メンテナンスやアフターサービスも簡素化される。

その結果、アップグレードによってGPU交換時のダウンタイムが短縮され、企業は顧客により信頼性の高いサーバーを提供できるようになる。

しかし、新しいソケット設計は、より高いレイテンシーをもたらすため、性能の低下をもたらすことが予想される。

それでも、メンテナンス、アップグレード、歩留まりが向上すれば、トレードオフは設計変更に見合うものになるだろう。

B300のもう一つの重要な変更点は、推論に有利なFP4(浮動小数点演算4)の採用である。

推論とは、学習済みモデルがデータに対して予測を行う方法であり、AI計算の重要な側面として機能する。

B200はすでにAIワークロードで卓越した性能を発揮し、さまざまな企業で導入されている。

一方、B300の 「Blackwell Ultra 」はその性能を大幅に向上させることが期待されているが、驚くべきことに、AMDはすでに2023年に発表したMI300Aチップでこの設計を導入しているため、ソケットベースの設計を採用するのはこれが初めてではない。

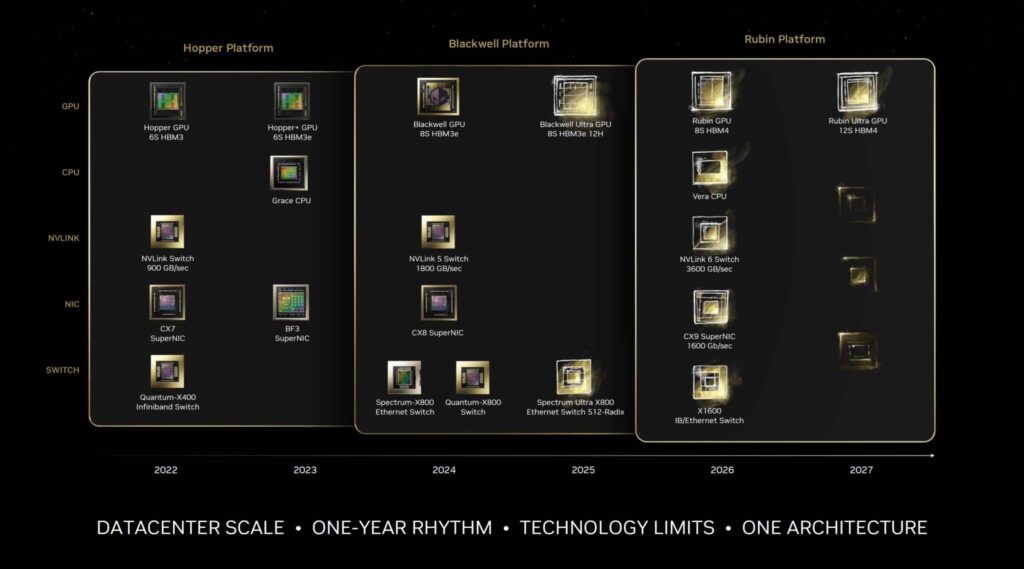

NVIDIA データセンター / AI GPU ロードマップ

| GPU コードネーム | X | Rubin (Ultra) | Blackwell (Ultra) | Hopper | Ampere | Volta | Pascal |

| GPUファミリー | GX200 | GR100 | GB200 | GH200/ GH100 | GA100 | GV100 | GP100 |

| GPU SKU | X100 | R100 | B100/ B200 | H100/ H200 | A100 | V100 | P100 |

| メモリー | HBM4e? | HBM4 | HBM3e | HBM2e/ HBM3/ HBM3e | HBM2e | HBM2 | HBM2 |

| 発売年 | 202X | 2026-2027 | 2024-2025 | 2022-2024 | 2020-2022 | 2018 | 2016 |

ソース:wccftech - NVIDIA Blackwell Ultra “B300” AI GPUs For GB300 Servers Might Utilize A Socketed Design

解説:

サーバー向けBlackwell Ultra「B300」GPUからソケットを採用

基盤直付けからソケットに変更になるようです。

電気的には不利になりますが、メンテナンス性が向上し、コスト的にも有利なようですね。

一般向けだと直付けからソケットへの変更はコスト的には微妙ですが、単価の高いサーバーの世界だと有利なのでしょうね。

代わりにレイテンシが大きくなるなどの性能面で悪影響を与えるとのこと。

どうにもサーバーの世界はピンときませんが、びっくりすることにAMDはすでにこのソケット形式を採用しています。

AMDはMCMもいち早く導入し、大容量のキャッシュも真っ先に取り入れました。

設計では革新的な取り組みが少ないですが、半導体技術をいち早く取り入れるという面では最先端クラスを走っていると思います。

一番最後の表ですが、AI向けサーバーGPUは毎年アーキテクチャーが更新されるといわれていましたが、Rubinは2026年で、結局は今まで通りということになります。

Blackwellはサーバーとコンシュマーとでアーキテクチャーが同一ですが、Hopperの例を見るとRubinは違うのでしょうね。

サーバー向けと対になる(まだ見ぬ)アーキテクチャーがあると思います。

とりあえずGeforceはCES2025でBlackwellが発表されることになりましたので来年まで動きはないと思います。

この辺り利益率の高いサーバー向けAIアクセラレーターが最優先なのでしょう。

AMDもRDNA4の上位モデルはキャンセルされましたし、とても残念です。

AMDのGPU Radeonシリーズ

Radeon 7000シリーズ

Radeon RX 6000シリーズ

※ SAPPHIREはAMD Radeon専業のメーカーであり、Radeonのリファレンス的なメーカーです。