目次

概要

最近ROCmでkohya_ss GUIのセットアップスクリプトを作成しておおよそ手順を理解したのでWindows+Geforce環境を使っている(おそらくは大多数の)ユーザーにも還元しようと思います。

Geforce用としては以前、「RTX4000用高速Stable Diffusion WebUI Ada(Automatic1111)配布」(現在では配布終了)という記事で配布していましたが、あの時よりはかなり理解が進みましたので、今回のスクリプトは前より進化し安定・快適になっています。

ぜひとも使ってみてください。

配布するもの

このスクリプトでできること

- pythonとGitはインストール不要

- PCのどこにでも好きな位置にインストール可能・移動可能。何ならUSBメモリにもインストール可能(遅いのでお勧めしません)

- ただし、インストールしたPCのインストールした環境でしか実行できません

- Stable Diffusion WebUIのセットアップ

- GUIでLoRAが作成できるkohya_ss GUIのセットアップ

- 上記のアップデート

検証環境

- CPU:AMD Ryzen 9 7950X

- CPUクーラー:Deep Cool AS620

- マザーボード:TUF Gaming X670E-PLUS

- SSD:M2_2(チップセット側PCIe Gen3×4) Moment MT34 NVMe Gen3 SSD 256GB(システムドライブ)

- 電源:Corsair ATX 1000W電源 RM1000e

- メモリ:Crucial DDR5-4800 定格メモリ16GB*2=32GB

- GPU:RTX4070Ti 12GB

- ケース:Fractal design Define R7 Wihte

- OS:Windows11 (最新大型パッチ及びWindows Update適用済)

準備するもの

PCはWindows11が実行できるもの、GPUは最低メモリ8GB・推奨12GB以上、RTX2000世代以降のGeforceが必要です。

それ未満のPCでも動作はしますが、快適に使用できないと思います。

上のsdwui_ptV2.zipを解凍して出てくるai-appというファルダを自分の好きな位置にコピーしてください。

ただしWindwosにはパス長260文字の制限があるのであまり深いパスにコピーするのはお勧めしません。

ほかには何も必要ありません。

後ほど検証しますが、cudatoolkitとcudnnをインストールする必要はありません。

免責事項

作成に当たっては複数回のテストを行っていますが、自己責任でお願いします。

使用することによって発生した損害などは一切免責とさせていただきます。

配布物の中に「MinGit-2.43.0-64-bit」と「Python3.10.6 Windows 64bit」が含まれていますが、ライセンスに基づき、未改変のバイナリをそのまま配布しています。

Stable Diffusion WebUIのインストール

コピーしたai-app中には以下のようになっています。

<フォルダ> misc

<フォルダ> system

SDXL_WUI.bat

update.bat

kohya_ss.bat

KOHYAFIX.bat

Readme.txt

sdwui.bat

Stable Diffusion WebUIのインストールに必要なファイルは「sdwebui.bat」と「SDXL_WUI.bat」です。どちらも中身はほぼ同じものです。

ダブルクリックで一回目はセットアップからインストール、Stable Diffsuion WebUIの起動までを行います。

一回目は

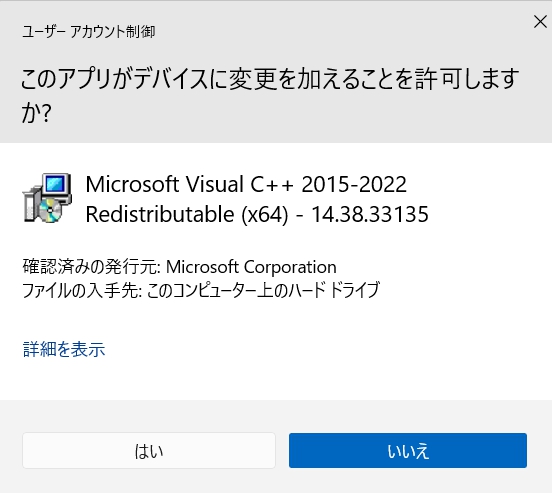

上のようなWindowsが表示されます。一番上に表示されない場合はタスクバーを見てマウスでクリックして一番上に表示させてください。

「はい」をクリックしてセットアップを進めてください。クリックしないとセットアップが進みません。

※ 設定によっては管理者のパスワードの入力が求められることがありますのでパスワードを入力してから「はい」をクリックしてください。

二回目以降はStable Diffsuion WebUIを起動します。

「sdwebui.bat」は「sd-wui」フォルダを作成してその中に「Stable Diffsuion WebUI」をインストールします。

「SDXL_WUI.bat」は「sdxl-wui」フォルダを作成してその中に「Stable Diffsuion WebUI」をインストールします。

同じものが二つあるのは「sdwebui.bat」はノーマルのStable Diffusion WebUI用、「SDXL_WUI.bat」はSDXL用です。

分けたほうが便利ですから、分けています。

このような配慮が不要な場合はどちらか片方だけを使ってください。

セットアップに失敗した場合

まずいないと思いますが、途中でポップアップするウィンドウに「いいえ」をクリックするなどしてセットアップに失敗した場合、「sd-wui」フォルダや「sdxl-wui」フォルダを削除して最初からやり直してください。

※ フォルダmiscの中にあるファイルの有無によって条件分岐しますので、フォルダを消したり中のファイルを消したりしないようにしてください。また、Stable Diffusion WebUIインストールフォルダ(sd-wui,sdxl-wui)、kohya_ss GUIインストールフォルダ(kohya_ss)の有無によってインストールの有無を判断していますので、削除したり移動したりしたうえでセットアップスクリプトを起動すると新たにインストールしますので注意してください。

kohya_ss GUIのインストール

「kohya_ss.bat」をダブルクリックして起動してください。

セットアップから初回起動まで

セットアップが終わると

Kohya_ss GUI setup menu:

1. Install kohya_ss gui

2. (Optional) Install cudann files (avoid unless you really need it)

3. (Optional) Install specific bitsandbytes versions

4. (Optional) Manually configure accelerate

5. (Optional) Start Kohya_ss GUI in browser

6. QuitEnter your choice:

コマンドプロンプトの中にこのような画面が表示されます。

必ず指示通りにセットアップしてください。

最初は半角で「1」を入力してエンターキーを押してください。

するとセットアップが始まります。

しばらく時間がかかります。

終了するとそのまま自動で「accelarate config」が始まります。

一つ目の質問

In which compute environment are you running?

Please select a choice using the arrow or number keys, and selecting with enter

上の問いには「* This machine」を選択してください。(そのままエンターキーを押すだけです。)

二つ目の質問

Which type of machine are you using?

Please select a choice using the arrow or number keys, and selecting with enter

上の問いには「 * No distributed training」を選択してください。(そのままエンターキーを押すだけです。)

三つ目の質問

Do you want to run your training on CPU only (even if a GPU / Apple Silicon / Ascend NPU device is available)? [yes/NO]:

上の問いには「 No 」を選択してください。(そのままエンターキーを押すだけです。)

四つ目の質問

Do you wish to optimize your script with torch dynamo?[yes/NO]:

上の問いには「 No 」を選択してください。(そのままエンターキーを押すだけです。)

五つ目の質問

Do you want to use DeepSpeed? [yes/NO]:

上の問いには「 No 」を選択してください。(そのままエンターキーを押すだけです。)

六つ目の質問

What GPU(s) (by id) should be used for training on this machine as a comma-seperated list? [all]:

上の問いには「 all 」を選択してください。(そのままエンターキーを押すだけです。)

七つ目(最後)の質問

Do you wish to use FP16 or BF16 (mixed precision)?

Please select a choice using the arrow or number keys, and selecting with enter

* no

fp16

bf16

fp8

RTX3000/RTX4000シリーズは数字の「2」を押してエンターキーを押してください。

それ以外のGPUの場合、「1」を押してエンターキーを押してください。

以上で終わりです。

Kohya_ss GUI setup menu:

1. Install kohya_ss gui

2. (Optional) Install cudann files (avoid unless you really need it)

3. (Optional) Install specific bitsandbytes versions

4. (Optional) Manually configure accelerate

5. (Optional) Start Kohya_ss GUI in browser

6. QuitEnter your choice:

また上のメニューが表示されますので、RTX3000/RTX4000シリーズをお持ちの方は「2」を押してからエンターキーを押してください。

それ以外の方は不要です。

14:04:52-474334 INFO Checking for CUDNN files in C:\ai-app\kohya_ss\venv\Lib\site-packages\torch\lib...

14:04:53-193200 INFO Copied CUDNN 8.6 files to destination

上のように表示されます。cudnnのセットアップを行っていますが、本来は事前に準備が必要です。しかし、必要なファイルはあらかじめダウンロードして解凍してありますので何もする必要はありません。

Kohya_ss GUI setup menu:

1. Install kohya_ss gui

2. (Optional) Install cudann files (avoid unless you really need it)

3. (Optional) Install specific bitsandbytes versions

4. (Optional) Manually configure accelerate

5. (Optional) Start Kohya_ss GUI in browser

6. QuitEnter your choice:

再度上のメニューが表示されますので、「6」を押してからエンターキーを押して終了してください。

「KOHYAFIX.bat」をダブルクリックして実行してください。

pipのインストールが進みます。終わったら自動で終了します。

この作業がおわつたら間違ってクリックしないように「KOHYAFIX.bat」を削除してください。

再度必要になったら「misc」の中に入っていますので、そこからコピーして使ってください。

終わったら再び「kohya_ss.bat」をダブルクリックします。

Kohya_ss GUI setup menu:

1. Install kohya_ss gui

2. (Optional) Install cudann files (avoid unless you really need it)

3. (Optional) Install specific bitsandbytes versions

4. (Optional) Manually configure accelerate

5. (Optional) Start Kohya_ss GUI in browser

6. QuitEnter your choice:

上のメニューが表示されますので、「5」押してからエンターキーを押すとkohya_ssが起動します。

以上でセットアップから初回起動までは終了です。お疲れさまでした。

次回以降も上のメニューが表示されますので同じように「5」を選択してエンターキーを押し、kohya_ss guiを起動してください。

LoRAカエルベンチマーク

LoRAカエルベンチマークとはkohya_ss GUIの作者さんが出してくださっている鳥獣戯画のカエル画像を利用したベンチマークです。

LoRAは使い始めるまでの準備が結構大変なので、ちゃんと正常に動作するのかどうかと自分のGPUがどのくらいの性能があるのかを手軽に確認するために添付してあります。

キャプションのテキストファイルも予め必要なことはすべて私が前処理してあります。

キャプションのテキストに関してはstable-diffusion-webui-wd14-taggerで作成しております。

ただし手直しなどはしていません。

今回のkohya_ssはポータブル版ですので、セッティングファイル、学習画像、正則画像、アウトプット、ログの5つのフォルダを指定する必要がありますが、それだけを設定すれば、簡単にLoRA学習を実行することができます。

配布デフォルトの位置は「C:\ai-app」になっています。

自分の環境に合わせてこれらを変更するだけで手軽にLoRAを出力してテストすることができます。

すでに自動でインストールされています。

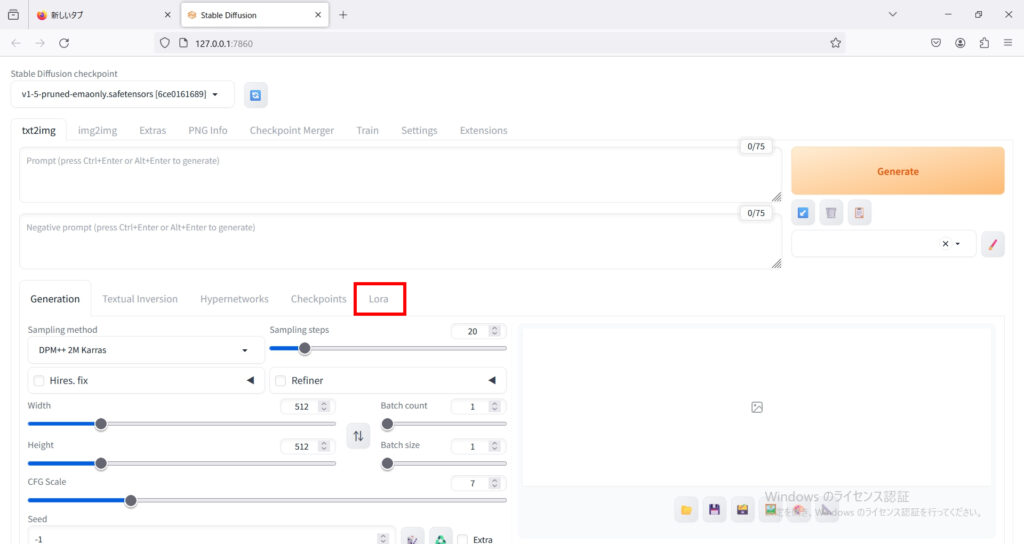

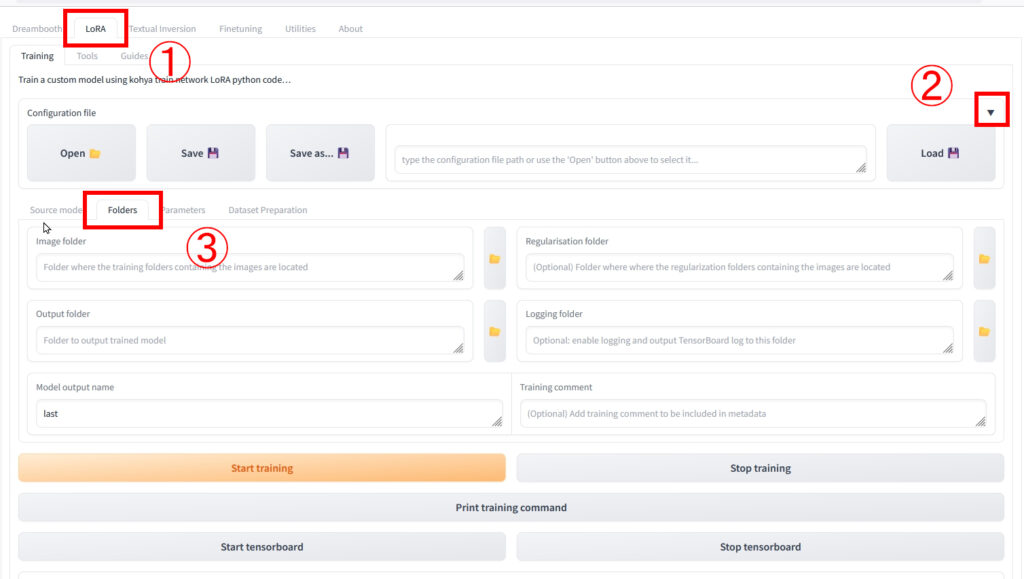

1 LoRAのタブを開いてください。ここはかなり忘れがちなのて注意してください。

2 Configuration Fileの横の◀をクリックして▼にして上の画像のようにメニューを展開してください。

3 Folderタブをクリックしてください。

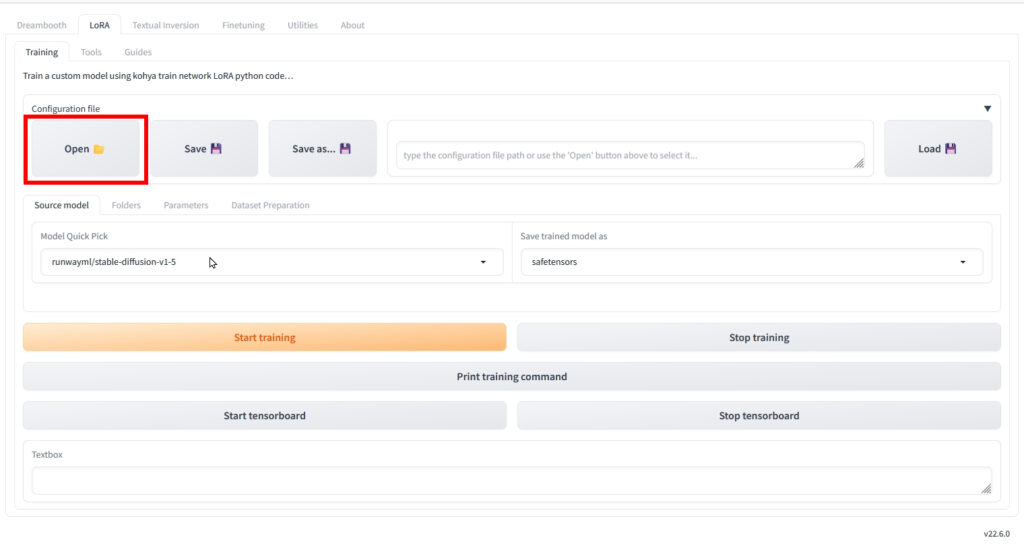

Openをクリックしてください。

ファイルの選択画面が現れますので、ファイルを選択します。

- frog_a8.json・・・AdamW8bitテスト用

- frog_a.json・・・AdamWテスト用

- frog_l8.json・・・Lion8bitテスト用

- frog_l.jsaon・・・Lionテスト用

となります。

ここはインストール場所によって違います。

Cドライブの直下にai-appをコピーした場合、「C:\ai-app\kohya_ss\users\settings」がわたくしが作成した設定ファイルの位置になります。

※ 画像をクリックすると別Window・タブで拡大します。

赤線で囲った部分のImage Folder、Regulation Folder、Output Folder、Loging Folderも先ほどの手順と同様に変更してください。

LoRAはsafetensorsファイルとしてOutputフォルダーに出力されます。

- Frog_A8.safetensors・・・AdamW8bitテスト用LoRA

- Frog_A.safetensors・・・AdamWテスト用LoRA

- Frog_L8.safetensors・・Lion8bitテスト用LoRA

- Frog_L.safetensors・・・Lionテスト用LoRA

LoRA生成の設定

accelerate launch --num_cpu_threads_per_process=4 "./train_network.py" --enable_bucket

--min_bucket_reso=256 --max_bucket_reso=2048

--pretrained_model_name_or_path="runwayml/stable-diffusion-v1-5"

--train_data_dir="C:/ai-app/kohya_ss/users/traning/lora_train_sample_pack/train"

--reg_data_dir="C:/ai-app/kohya_ss/users/traning/lora_train_sample_pack/reg"

--resolution="512,512" --output_dir="C:/ai-app/kohya_ss/users/output"

--logging_dir="C:/ai-app/kohya_ss/users/logs" --network_alpha="2" --save_model_as=safetensors

--network_module=networks.lora --network_dim=64 --output_name="Frog_A8"

--lr_scheduler_num_cycles="2" --learning_rate="0.0001" --lr_scheduler="cosine"

--lr_warmup_steps="84" --train_batch_size="1" --max_train_steps="1200"

--save_every_n_epochs="5" --mixed_precision="fp16" --save_precision="fp16"

--caption_extension="txt" --optimizer_type="AdamW8bit" --max_grad_norm="1"

--max_data_loader_n_workers="0" --clip_skip=2 --bucket_reso_steps=64 --xformers

--bucket_no_upscale --noise_offset=0.0

です。こちらは「ちもろぐ」さんの設定を参考にさせていただきました。ありがとうございます。

「ちもろぐ」さんはkohya_ss sd-scriptを使用しています。

同じ作者さんのものなのですが、sd-scriptのほうが高性能のようです。

設定を同一にしても同じ結果にはなりませんでしたので、おそらく、kohya_ss GUIはRTX4000シリーズの性能をまだうまく引き出せないのだと思います。

もし、わたくしの設定ミスなどがあったら訂正させていただきますのでご指摘いただけると幸いです。

テスト

出来上がったLoRAは「sd-wui\models\Lora」中にコピーしてください。

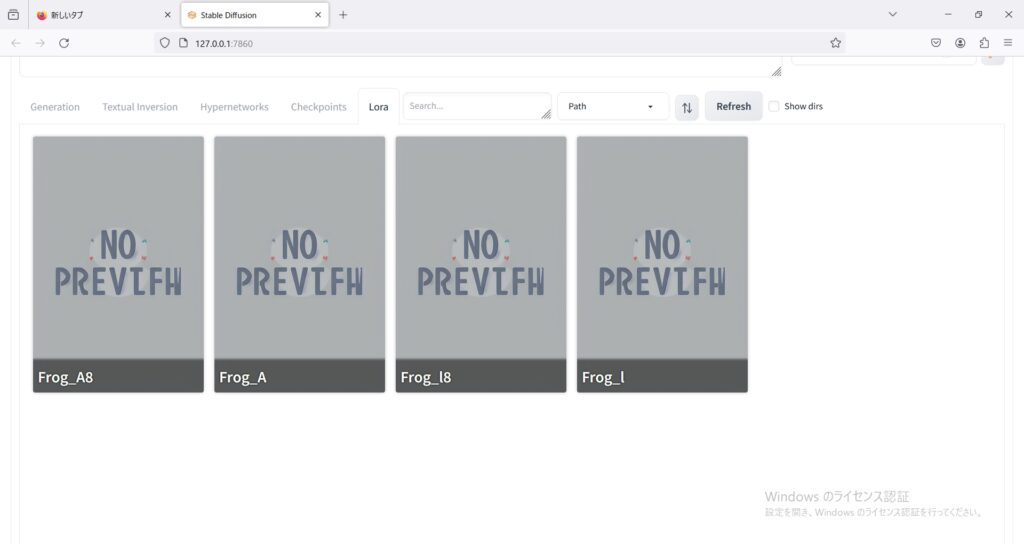

Stable Diffusion WebUIを起動して下の画像のように表示されたら成功です。

※ 画像をクリックすると別Window・タブで拡大します。

LoRAのタブを開いて上のように表示されたら成功です。

LoRAの作成に当たってはこちらのモデルを使っております(kohya_ss GUIデフォルト)

わたくしがテストするときも上のリンクのモデルを使っておりますので参考にしてください。

わたくしがテストに使用した生成ワードは「usu frog」でネガティブワードはありません。

LoRAを使用してイラスト調に絵が変わったら成功です。

お疲れさまでした。

本気で使ってみようという方はほかのサイトさんを参考にしてください。

人工知能と親しくなるブログ - 誰でもわかるStable Diffusion LoRAを作ってみよう(実践編)

使い方が詳しく書いてあり、参考になります。

人工知能と親しくなるブログ - 誰でもわかるStable Diffusion kohya_ssの追加パラメータを解説

kohya_ssのあまりにも多い各オプションの意味についてはこちらに詳しく解説されています。

アップデートについて

「update.bat」をダブルクリックすると「sd-wui」、「sdxl-wui」、「kohya_ss」に対してアップデートをかけます。

存在しない場合(インストールしてない場合)は飛ばします。

「kohya_ss」に関してはインストールされている場合、アップデート後、「setup.bat」を呼び出します。

Kohya_ss GUI setup menu:

1. Install kohya_ss gui

2. (Optional) Install cudann files (avoid unless you really need it)

3. (Optional) Install specific bitsandbytes versions

4. (Optional) Manually configure accelerate

5. (Optional) Start Kohya_ss GUI in browser

6. QuitEnter your choice:

「1」を入力してエンターキーを押してください。

終わったらまた再度上のメニューが表示されますので、「6」を押してエンターキーを押してください。

検証環境における性能テストとcudatoolkitとcudnnが性能に及ぼす影響

Stable Diffusion WebUIの動作のハウトゥーに必ずcudatoolkitとcudnnのインストールが必要とされているが、本当に必要なのかどうかこの機会に検証してみました。

cuda_11.8.0_522.06_windows

CUDA Toolkit インストールオプション 高速(推奨)

CUDA Visual Studio Intergrationインストール

CUDA_PATH

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8

CUDA_PATH_V11_8

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8

システム環境変数PATHへの追加

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\bin;C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\libnvvp;

cudnn-windows-x86_64-8.9.7.29_cuda11-archive

インストール先

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8

CUDNN_PATH

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8

zlib123dllx64

インストール先

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\bin

Stable Diffusion WebUI

cudatoolkit・cudnn両方なし、cudatoolkitのみあり、cudatoolkit・cudnn両方ありの条件でテスト

テスト方法

ハローアスカベンチマークを各条件で3回実行し、最も数値の良かったものを採用

| cudatoolkit cudnn両方無し | Cudatoolkit のみあり | cudatoolkit cudnn両方あり | |

| Time to Taken | 16.6s | 16.6s | 16.6s |

| Total it/s | 20.6 | 20.08 | 19.44 |

※ Time to taken=小さいほど性能が良い、Total it/s=大きいほど性能が良い

上のようになった。特に早くなっているということはなく、若干速度が落ちているようにすら見える。

結論:cudatoolkit+cudnnはなくても動作するし、あり・なしで性能に影響が出ることはない。

kohya_ss GUI

cudatoolkit・cudnn両方なし、cudatoolkitのみあり、cudatoolkit・cudnn両方ありの条件でテスト

テスト方法

設定ファイルに記録したLoRAカエルベンチマークを実行した。

| cudatoolkit cudnn両方無し | Cudatoolkit のみあり | cudatoolkit cudnn両方あり | |

| AdamW | 4.19 | 3.42 | 4.2 |

| AdamW8bit | 4.12 | 3.96 | 4.25 |

| Lion | 3.85 | 4.06 | 4.14 |

| Lion8bit | 4.16 | 4.18 | 3.93 |

※単位it/s(大きいほど性能が良い)

こちらも有意な性能向上は見られなかった。

結論:cudatoolkit+cudnnはなくても動作するし、学習においてもあり・なしで性能に影響が出ることはない。

では本当にcudatoolkitとcudnnは性能に影響を与えないのか?

kohya_ssではセットアップの時にcudnnを独自のURLからダウンロードして解凍してkohya_ssフォルダの中にコピーする必要があることを注意しています。

kohya_ss付属のスクリプトの中を見る以下のファイルを「kohya_ss\venv\Lib\site-packages\torch\lib」内にコピーする設定になっています。

cudnn64_8.dll

cudnn_adv_infer64_8.dll

cudnn_adv_train64_8.dll

cudnn_cnn_infer64_8.dll

cudnn_cnn_train64_8.dll

cudnn_ops_infer64_8.dll

cudnn_ops_train64_8.dll

つまり、pytorchの公式バイナリの中にはcudnnのライブラリが一部含まれており、それをgithubからダウンロードしたcudnnで上書きしているということになります。

動作としては「sd-wui\venv\Lib\site-packages\torch\lib」や「kohya_ss\venv\Lib\site-packages\torch\lib」内にあるcudnn(上の7ファイル)があるのでシステム環境変数PATHに登録されているcudatoolkit内(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8\bin)にある最新のファイルを読みに行ってないということになります。

よって、cuda11.8対応の最新のcudnnをダウンロードして、解凍し、kohya_ss付属のスクリプトがコピーしているファイルだけコピーしてテストしてみました。

正常に動作しなかったり不具合が起きる可能性があるので、既存のファイルはsd-wui\venv\Lib\site-packages\torch\lib」や「kohya_ss\venv\Lib\site-packages\torch\lib」内に「old」というフォルダを作ってバックアップしておきましょう。

nvidia公式cudnnダウンロードページ(ダウンロードには登録が必要です。)

この記事を執筆している時点の最新版は「cudnn-windows-x86_64-8.9.7.29_cuda11-archive.zip」でした。

「\venv\Lib\site-packages\torch\lib」内ファイル置き換え後にテスト

Stable Diffusion WebUI

| cudatoolkit cudnn両方無し | Cudatoolkit のみあり | cudatoolkit cudnn両方あり | venv内 ファイル置き換え | |

| Time to Taken | 16.6s | 16.6s | 16.6s | 16.3s |

| Total it/s | 20.6 | 20.08 | 19.44 | 20.03 |

※ Time to taken=小さいほど性能が良い、Total it/s=大きいほど性能が良い

上の表ではわかりにくいがテストが3回とも20it/sを超え、ほんのわずかだが速くなるようだ。

kohya_ss GUI

| cudatoolkit cudnn両方無し | Cudatoolkit のみあり | cudatoolkit cudnn両方あり | venv内 ファイル置き換え | |

| AdamW | 4.19 | 3.42 | 4.2 | 4.33 |

| AdamW8bit | 4.12 | 3.96 | 4.25 | 4.11 |

| Lion | 3.85 | 4.06 | 4.14 | 4.12 |

| Lion8bit | 4.16 | 4.18 | 3.93 | 4.13 |

※単位it/s(大きいほど性能が良い)

こちらもすべてのテストで4it/sを超え、安定的に速くなった。

つまり、Stable difussion WebUIやkohya_ssなどの公式pytorchを使う場合、最新版のcudnnを使うとは「\venv\Lib\site-packages\torch\lib」内のファイルを置き換えるという意味だということだ。

ではcudatoolkitとcudnnはどんな時に必要なのか?

cudatoolkitとcudnn(とzlib+Build Tool for Visual Studio)はどんな時に使うのだろうか?

それはpythonやAI/MLのフレームワークで開発を行う場合や、stable diffusion webuiやkohya_ss guiの使用にあってはxformersなどのモジュールを自分の手でビルドする場合には必要になる。

なぜこのような但し書きがつくようになったのかを推測すると、初期の頃にはxformersなどのモジュールを少なからぬ頻度で自分の手でビルドする必要があったのではないだろうか?

それでこれらのソフト環境が「必要」とされるようになったのではないだろうか?

現在ではたいていの場合、バイナリをビルドしなくても実行できるようになったので不要になったのではないだろうか?

正常に動かない場合

正常に動かない場合の対処方法

正常に動作しない場合、おそらくは9割方が「システム環境変数PATHの文字数オーバーフロー問題」が原因だと思われます。

この問題は「システム環境変数PATH」の文字数上限が2047文字までというWindowsの欠陥的仕様が原因で起こります。

普通の変数の文字数制限は32767文字までなのですが、なぜかWindowsの仕様上最も多くの文字列が登録されそうな「システム環境変数PATH」だけが2047文字と極端に少ない文字数制限が存在します。

「システム環境変数PATH」はコマンドプロンプトを開き、「SET PATH」と入力すると表示されます。

ここが2047文字を超えるとPATHが正常に働かなくなりますので、今回のスクリプトも正常に動かなくなります。

解決方法:

今回配布しているバッチファイルすべてに以下の部分があります。

rem システム環境変数オーバーフロー対策Windows10

rem setPATH=%DIR%\minGit\cmd;%DIR%\python;%DIR%\python\Scripts;%SystemRoot%\system32;%SystemRoot%;%SystemRoot%\System32\Wbem;%SYSTEMROOT%\System32\WindowsPowerShell\v1.0\rem システム環境変数オーバーフロー対策Windows11

rem set PATH=%DIR%\minGit\cmd;%DIR%\python;%DIR%\python\Scripts;%SystemRoot%\system32;%SystemRoot%;%SystemRoot%\System32\Wbem;%SYSTEMROOT%\System32\WindowsPowerShell\v1.0\;%SYSTEMROOT%\System32\OpenSSH\set PATH=%DIR%\minGit\cmd;%DIR%\python;%DIR%\python\Scripts;%PATH%

一番下の「set PATH=...」から始まる行の先頭に「rem 」をつけてください。

Windows10の場合は「rem システム環境変数オーバーフロー対策Windows10」の下の行の「rem」を外してください。

Windows11の場合は「rem システム環境変数オーバーフロー対策Windows11」の下の行の「rem」を外してください。

「rem システム環境変数オーバーフロー対策Windows11」自体の「rem」は外さないように注意してください。

これで解決しますが、今回のスクリプトを使っている間は「システム環境変数PATH」を追加したソフトウェアは正常に作動しません。

その点は注意してください。

2024/2/08前後からのエラーについて

起動しようとするとこのようなメッセージを出して止まります。

ImportError: cannot import name 'set_documentation_group' from 'gradio_client.documentation'

この手の問題は時間が解決すると思われますが、こちらでも解決方法を記しておきます。

インストールしたai-appの中に「新しいファイル」を作って、mt.batと名前を変更してください。

メモ帳で編集して以下をコピペしてください。

@echo off

set DIR=%~dp0system

rem システム環境変数PATHオーバーフロー対策 - Windows10

rem setPATH=%DIR%\minGit\cmd;%DIR%\minGit\mingw64\bin;%DIR%\minGit\usr\bin;%DIR%\python;%DIR%\python\Scripts;%SystemRoot%\system32;%SystemRoot%;%SystemRoot%\System32\Wbem;%SYSTEMROOT%\System32\WindowsPowerShell\v1.0\

rem システム環境変数PATHオーバーフロー対策 - Windows11

rem set PATH=%DIR%\minGit\cmd;%DIR%\minGit\mingw64\bin;%DIR%\minGit\usr\bin;%DIR%\python;%DIR%\python\Scripts;%SystemRoot%\system32;%SystemRoot%;%SystemRoot%\System32\Wbem;%SYSTEMROOT%\System32\WindowsPowerShell\v1.0\;%SYSTEMROOT%\System32\OpenSSH\

set PATH=%DIR%\minGit\cmd;%DIR%\minGit\mingw64\bin;%DIR%\minGit\usr\bin;%DIR%\python;%DIR%\python\Scripts;%PATH%

cmd /k

このバッチファイルを実行すると、黒い画面(コマンドプロンプト)が出たまま終わります。

そこで、

cd kohya_ss

venv\Scripts\activate.bat

pip install gradio_client==0.8.1

上のように入力して各行の終わりはエンターキーを入力してください。

最後の行を打つとpipが動作してgradio_clientが入れ替えられるはずです。

終わったら黒い画面を閉じてもOKです。

あとは普通に動作するはずです。

ちなみにこの問題はLinuxでも確認されていすまので、同じ症状が出た方は同じように処理してください。