AIとHPCのメガトレンドは、高度なパッケージングへの要求を後押ししています。

人工知能(AI)、ハイパフォーマンス・コンピューティング(HPC)、PCなど、近年、先端プロセス技術の需要が急速に高まっており、大手チップメーカーはそれに対応するために最先端の生産能力を拡大しています。

どうやら、NvidiaのA100やH100のような高度な計算GPUの需要は非常に高く、TSMCは現在、高度なパッケージング能力の拡張を計画していると、DigiTimesの報道は伝えています。

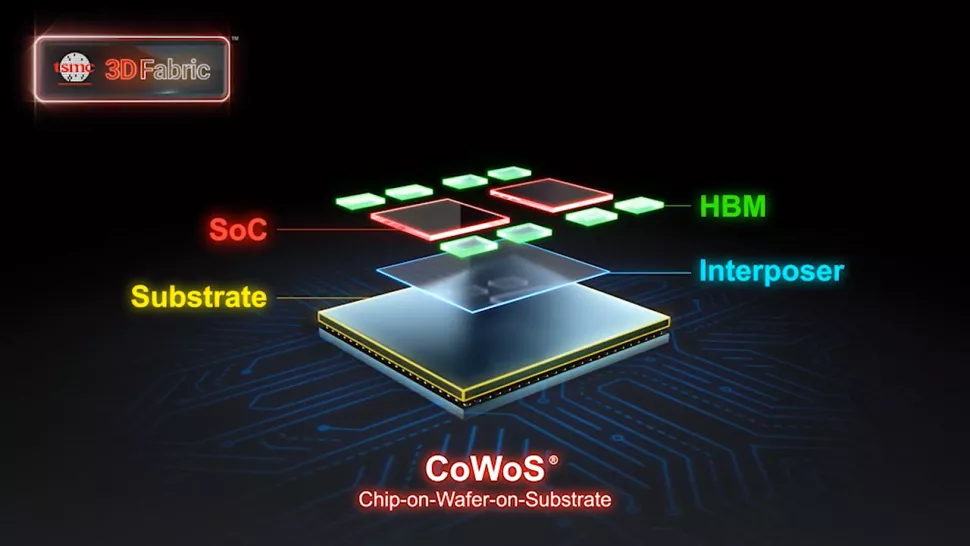

CoWoS(チップ・オン・ウェハ・オン・サブストレート)のようなパッケージング技術に対する現在の需要は、利用可能な能力をはるかに上回っており、そのためTSMCは現在、こうした生産能力を高めるための取り組みを加速していると、同レポートは伝えている。

TSMCは、2023年の期間中、Nvidiaのために10,000枚のCoWoSウェハーを追加で加工することを約束したと報告されています。

Nvidiaが1枚のウェハーに約60個のA100/H100 GPU(H100はわずかに小さい)を搭載することを考えると、追加で60万個のトップエンドデータセンターGPUを搭載できることになります。

この予測は、今年の残りの期間、毎月約1,000~2,000枚ずつ増加することを意味する。

TSMCの月間のCoWoS生産量は8,000~9,000枚の間で推移しており、Nvidiaに月1,000~2,000枚を追加供給すれば、TSMCのハイエンドパッケージ設備の稼働率が大幅に向上する。

このような高騰は、需要の高まりにより、他の業界プレイヤーにとってCoWoSサービスの供給不足につながる可能性があり、そのためTSMCは高度なパッケージング能力を拡大する計画だと伝えられています。

TSMCの増産は、業界全体で幅広く採用されているNvidiaのAIチップの需要増をサポートすることが目的とされています。

例えば、Googleは最近、NvidiaのH100をベースにした新しいA3スーパーコンピュータを発表し、26ExaFLOPSのAI性能を誇った。

同様に、Microsoft、Oracle、さらにはElon Muskが設立予定のAIベンチャーなど、複数の著名企業が過去数カ月の間に数万個のNvidiaのAI GPUを調達しています。

Nvidiaの現在の製品群には、A100、A30、H100、および中国専用のA800とH800 GPUが含まれているため、どの特定のコンピュートGPUを強化するつもりなのかはまだ不明である。

TSMCの高度なパッケージングサービスを提供する施設は、すべて台湾にある。

ソース:Tom's Hardware - TSMC Adds Advanced Packaging Capacity to Meet Nvidia Demands: Report

解説:

ゲーム用のGPUが売れなくてもnVIDIAのはちっとも困ってない。

私はツイートで何度も繰り返していますが、それを裏付けるようなニュースが入ってきました。

世はAIブームでデータセンター向けのAI演算用チップは飛ぶように売れています。

単価の安いゲーム用のGPUなど売れなくてもnVIDIAは痛くもかゆくもないということです。

売れなくて余った容量はデータセンター・HPC向けの生産に振り向ければよいだけですから。

普通は売れなかったら困るのですが、困るのはAIB以下パーツを生産している企業の下流にいる人たちだけでnVIDIA本体は全く無傷でしょう。

売れなければ生産調整して流すのを辞めればよいだけです。

ゲーム用PCパーツの生産企業以下流通・小売・消費者などは困るかもしれません。

しかし、nVIDIAは単価が高くて利益率が高く、是非売ってくれと頭を下げてくる企業が山ほどいるわけですから、そちらに別のラインの製品を売ればよいだけの話です。

まさに「嫌なら買うな」が成立してしまっているわけです。

我々はどうすればよいのでしょう?

残念ながら一般人に出来ることは何もありません。

nVIDIAの言い値でGeforceを売ってくださいとお願いするしかないのです。

nVidia RTX4000SUPER

nVidia RTX4000

nVidia RTX3000シリーズGPU

RTX3060 12GB GDDR6

RTX3050 6GB