大衆のためのAI。

Computex 2023の期間中、ここ台湾の台北にあるAMDのオフィスを訪れ、同社のコーポレートVP兼クライアント・チャネル・ビジネス担当ゼネラル・マネージャーのDavid McAfeeと対談しました。

また、AMDのRyzen XDNA AIエンジンがラップトップのデモで動作しているのを見る機会もあり、McAfeeは、PC上でローカルに動作する急成長中のAIユースケースに向けて、OSとソフトウェアのエコシステムを準備するためにAMDが取っているステップについて説明しました(以下、さらに掘り下げます)。

AMDのコードネームにインスパイアされた廊下マップに従った後、私はAMDの最新技術を実際に見るためのデモルームへの道を見つけました。

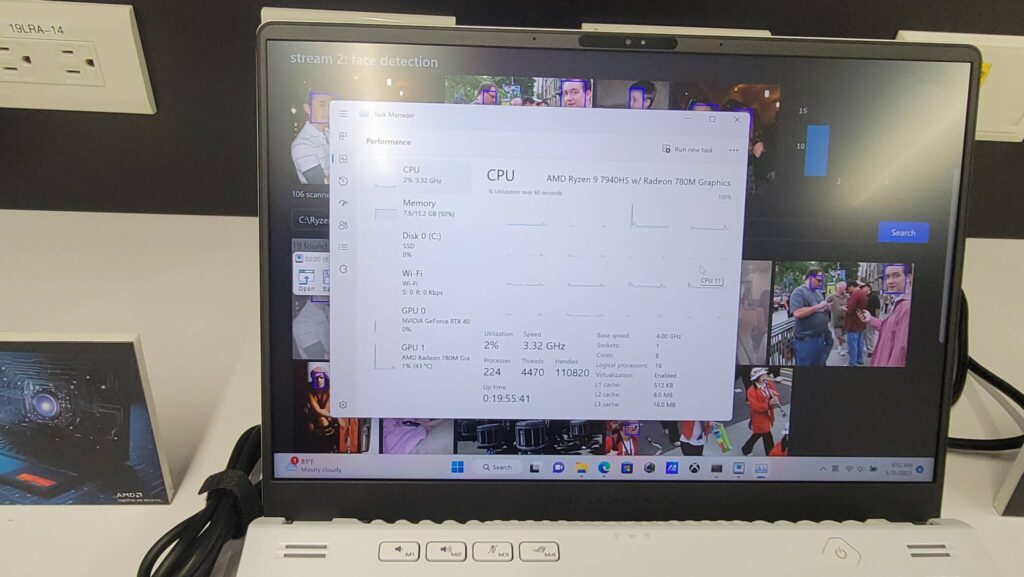

AMDのデモ用ノートパソコンは、Asus Strix Scar 17で、AMDの4nm「Phoenix」Ryzen 9 7940HSプロセッサーとRadeon 780Mグラフィックスを搭載している。

これらの35~45Wのチップは、Zen 4アーキテクチャとRDNA 3グラフィックスを搭載しています。

AMDはまた、Asus ROG Zephyrus G14で同じデモを走らせていた。

XDNA AIエンジンは、CPUコアと一緒にオンダイに存在する専用アクセラレータである。

XDNA AIエンジンの目標は、オーディオ、写真、ビデオ処理のような低強度のAI推論ワークロードを、CPUやGPUで実現するよりも低い電力で実行しつつ、オンラインサービスよりも速い応答時間を実現し、パフォーマンスの向上とバッテリー電力の節約を図ることです。

まず、AIエンジンが利用指標を持つ可視コアとして列挙されるかどうかを確認するためにタスクマネージャをポップオープンしましたが、XDNA AIエンジンはタスクマネージャに可視デバイスとして表示されません。

上のアルバムにあるように、デバイスマネージャーでAIエンジンが「AMD IPU Device」として表示されているのを発見しました。

しかし、テスト中にコアから負荷などのテレメトリを観測することはできなかった。

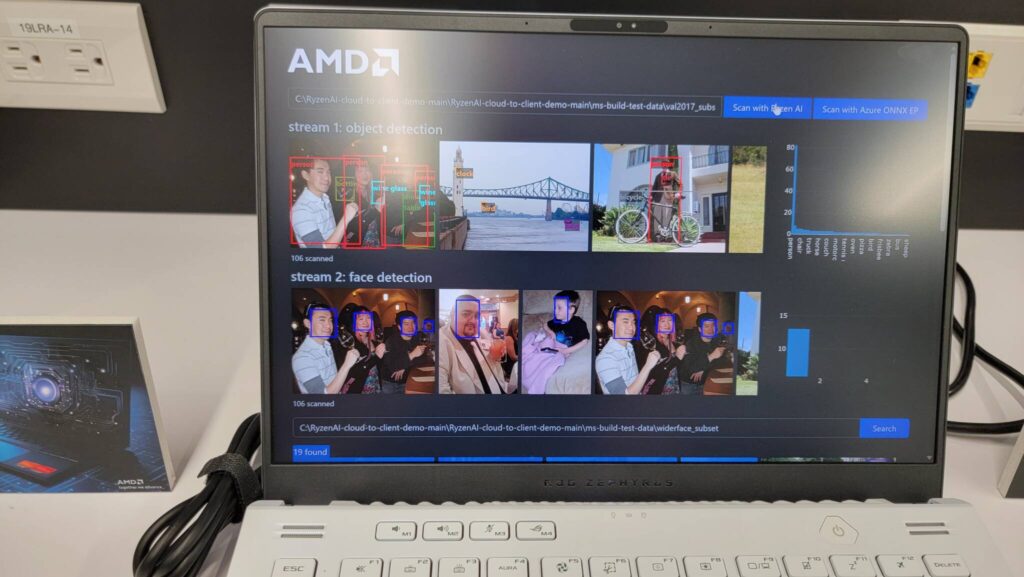

ここでは、XDNA AIエンジンが顔認識ワークロードを処理する様子を見ることができます。画面の右側には、ワークロードの各ステップにおけるレイテンシーの測定値が表示されています。

バーが驚くほど低く、AIエンジンが推論ワークロードを処理する際に、ワークロードは一連の画像を通して素早く実行されましたが、この数値が他のタイプのソリューションと比較してどうなのかという文脈はありません。

AMDのデモでは、オンボードのAIエンジンをオンラインのAzure ONNX EPサービスとテストするボタンがありましたが、デモチームは、ソフトウェアに問題が発生したため、動作しなかったと述べています。

当然、内蔵のRyzen AIエンジンはAzureサービスよりもレイテンシーが低いと予想され、論理的には、それがAMDが実証しようとしていたことです。

しかし、残念ながら、ベンチマーク結果に対する実質的な比較対象がないまま、私たちは去ってしまいました。

しかし、このベンチマークは、AMDのRyzen 7040プロセッサーでAIが生きていることを示すものであり、同社は、AIエンジンを活用できるアプリケーションの数を強化することも進めている。

このエンジンは、最大4つのAIストリームを同時に処理できますが、さまざまなストリームを処理するために迅速に再構成することが可能です。

また、INT8命令とbfloat16命令を処理します。これらの低精度データ型は、他のデータ型に比べて電力効率が非常に高く、少なくともAI推論のようなワークロードでは、そのメリットを活用することが可能です。

AMDは、Xilinx IPの子孫であるこのエンジンは、AppleのM2プロセッサーに搭載されているニューラルエンジンよりも高速であると主張しています。

このエンジンは、チップのメモリ・サブシステムに直接接続されているため、CPUや統合GPUとコヒーレント・メモリのプールを共有し、コストのかかるデータ転送を排除して、電力効率と性能を再び向上させることができます。

AMDは先週、MicrosoftのBuildカンファレンスで、XDNA AIエンジンのソフトウェアサポートを追加するために必要な作業を容易にするために、オープンソースのVitis AI Execution Provider(EP)を活用し、それをONNXランタイムでアップストリームする新しい開発者ツールセットを作成したと発表しました。

マカフィーは、Vitis AI EPは、開発者がベースモデルを変更することなくモデルを実行できるようにする、一種のベアメタル翻訳レイヤーとして機能すると説明しています。

そのため統合が簡素化され、AMDの実装は現在、IntelがMeteor Lake内部のVPUで使用しているAdobeなどと同じアプリケーションで動作するという。

また、Intelのアプローチと同様に、AMDは異なるAI推論ワークロードを、ワークロードのニーズに基づいて、CPU、GPU、XDNAエンジンなど、正しいタイプのコンピュートに誘導する。

AMDはまだAIエンジンの性能指標を提供していないが、McAfee氏は、電力効率の向上やレイテンシーの低下は、AIエンジンを搭載することによる多面的なメリットの一部であるため、TOPSなどの1つの性能指標だけでAIエンジンを搭載するメリットを定量化するのは難しいと指摘する。

AMDは将来的に数値を共有するだろうが。

McAfee氏は、AMDがXDNA AIロードマップを引き続き実行し、最終的には将来的に他のRyzenプロセッサにも同エンジンを追加する予定であることを改めて強調した。

しかし、PCにおけるAIのソフトウェア・エコシステムはまだ初期段階にあり、AMDはトレードオフと現実的な利点の対比を引き続き探っていくことになる。

AIエンジンを内蔵する利点の多くは電力効率にあり、ノートPCのような電力制約のあるデバイスでは必須ですが、制約のないデスクトップPCでは、より強力な専用GPUやCPUを推論ワークロードに使用できるため、それほど意味がないのかもしれません--ただしバッテリー寿命の懸念はありません。

XDNAをデスクトップPCに搭載するかどうかというAMDの判断に、こうした要素が影響する可能性があるかどうかをMcAfee氏に尋ねたところ、「このエンジンに貴重なダイ領域を割く意味があるほど、この機能が価値をもたらすかどうかに集約されるだろう」と回答した。

AMDは、特にRyzen 7040が市場に浸透していく中で、その影響を評価中である。

今のところ、AMDは将来の計画を確認していないが、McAfee氏は、AMDはAIエンジンが将来のロードマップの一部であることにコミットしているが、すべての製品に搭載されないかもしれないと述べた。

その点、デスクトップPCのように、AMDのチップレット戦略を活用した別のタイプのチップのオプションが考えられるという。

また、アドインカードのような他のオプションも、可能なソリューションである。

ひとつ確かなことは、スケーラブルな統合型XDNA AIエンジンが、今後もAMDの多くの製品に登場することです。

次回は、もっと良いデモが見られると良いですね。

ソース:Tom's Hardware - AMD Demoes Ryzen AI at Computex 2023

解説:

ComputexでPHoenix PointのAIエンジンのデモが行われたようです。

APUにはAIEが搭載されることは明言されているわけですが、デスクトップに関してはハッキリしていないようです。

IntelのVPUの記事を見ると、それなりの速度で動くような印象を受けましたが、AMDのこの記事を見ると、GPUがあれば必要ない程度の性能しかやはりないようです。

Poenix Pointの場合、内蔵GPUの規模も小さいので、このAIEを使うことによって低消費電力でなおかつGPUのAIワークロードを支援できるような仕組みになっているのならば結構存在する意味は大きいと思いますが、ハイエンドGPUと比較するとやはりあまり意味が無いものなのかもしれません。

AIは大規模モデルが限界を迎えていると言われているので、今度はローカルPCで実行するプログラムと言う形で降りてくるのが今後のトレンドになりそうな気配です。

何れにしても、IntelもAMDもついでにAppleもAIのアクセラレーターと言う同じ目的のシリコンを搭載したわけです。

このAIアクセラレーターを使って、どのような用途が出てくるのか注目しています。

きっと1年後にはあるのが当たり前になっているのもしれません。

今のAI関連のサービス・ソフトウェア、エコシステムの進化の速さを見ているとそんな風に感じます。

私がStable Diffusion WebUIを本格的に触り始めたのが今年の2月からだったと思いますが、そこからだけでも怒涛の進歩で情報をキャッチアップするのに苦労していますが、1年後には見えている景色が全然違うと思います。

その進化の速さに戦慄を抱きつつも、良い方向に向かってほしいなあと思います。

最悪、社会に対するとんでもない爆弾になる可能性もありますから。

AMDさんにはRyzen 7 7700G/5 7600Gも速くリリースしてほしいです。

Ryzen 9000シリーズ

Ryzen 7000X3Dシリーズ

Ryzen 8000GシリーズAPU(GPU内蔵)

Ryzen 5000/4000シリーズ