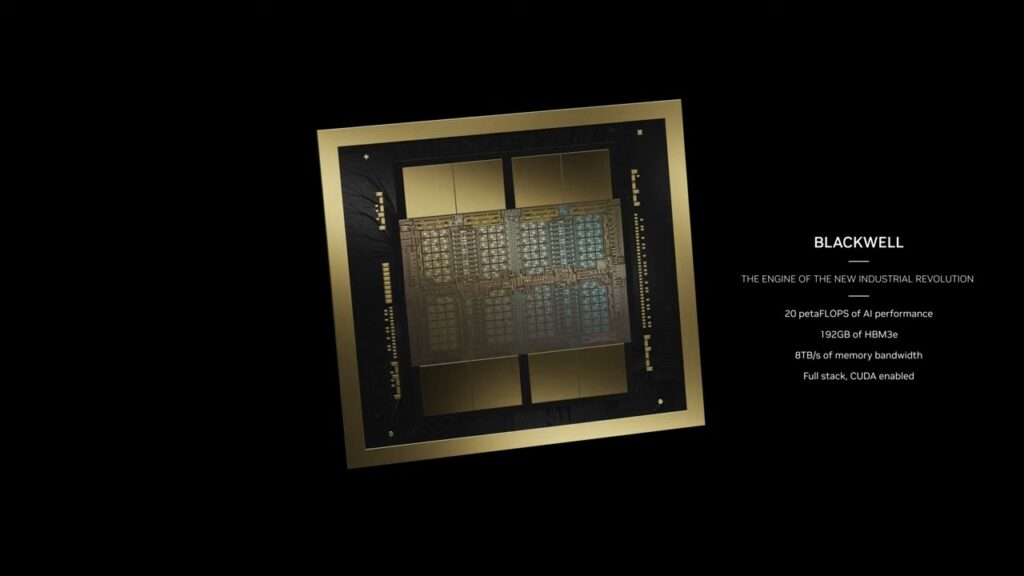

デュアルダイのB200 GPUは、AIトレーニング性能が従来の4倍、推論性能が30倍となっている。

Nvidiaは現在、誰もが欲しがるデータセンター向けGPUで、AIの世界のトップに君臨している。

そのHopper H100とGH200 Grace Hopperスーパーチップは深刻な需要があり、世界で最もパワフルなスーパーコンピューターの多くを動かしている。

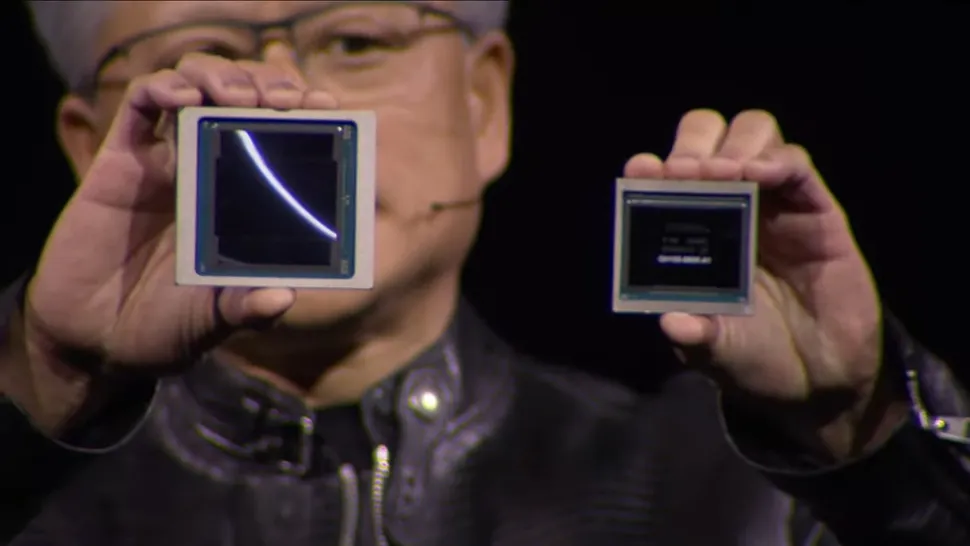

NvidiaはHopperの後継機を発表した。ジェンセン・フアン最高経営責任者(CEO)は本日、次世代データセンターおよびAI GPUであるBlackwell B200を発表した。

BlackwellアーキテクチャとB200 GPUは、H100/H200を引き継ぐ。

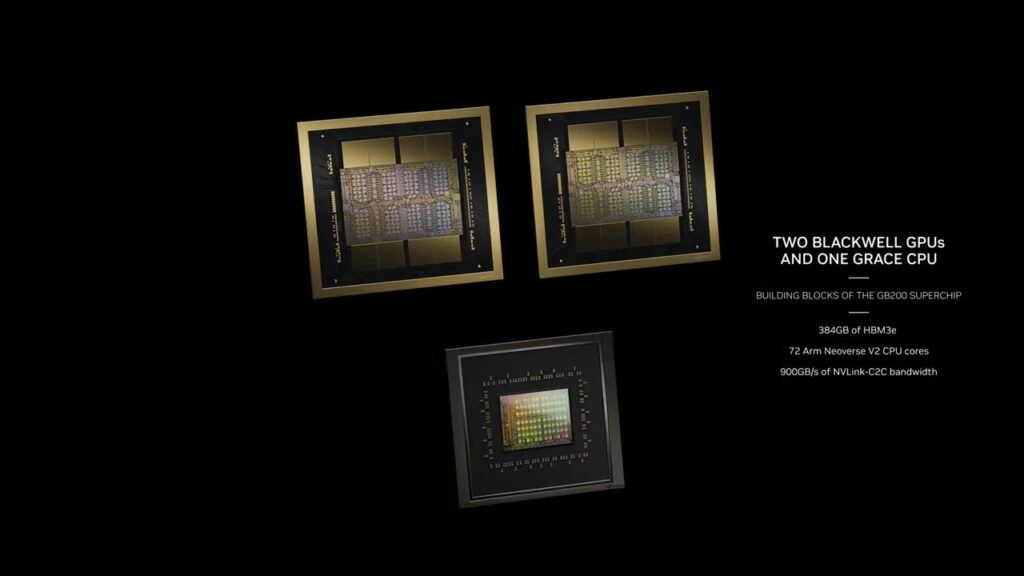

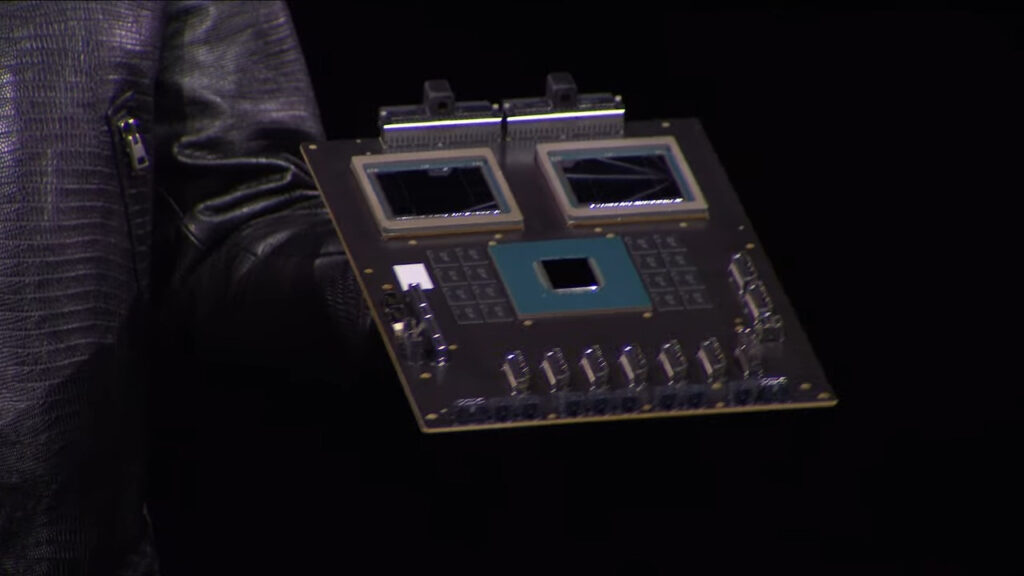

また、Grace Blackwell GB200スーパーチップも登場し、その名前から推測できるように、Grace CPUアーキテクチャはそのままに、アップデートされたBlackwell GPUと組み合わせられる。

Nvidiaは最終的にコンシューマー・クラスのBlackwell GPUも用意すると予想しているが、それらは2025年まで登場しない可能性があり、データセンター・チップとはかなり異なるものになるだろう。

Nvidiaは現在、誰もが欲しがるデータセンター向けGPUで、AIの世界のトップに君臨している。

そのHopper H100とGH200 Grace Hopperスーパーチップは深刻な需要があり、世界で最もパワフルなスーパーコンピューターの多くを動かしている。

NvidiaはHopperの後継機を発表した。ジェンセン・フアン最高経営責任者(CEO)は本日、次世代データセンターおよびAI GPUであるBlackwell B200を発表した。

BlackwellアーキテクチャとB200 GPUは、H100/H200を引き継ぐ。

また、Grace Blackwell GB200スーパーチップも登場し、その名前から推測できるように、Grace CPUアーキテクチャはそのままに、アップデートされたBlackwell GPUと組み合わせられる。

Nvidiaは最終的にコンシューマー・クラスのBlackwell GPUも用意すると予想しているが、それらは2025年まで登場しない可能性があり、データセンター・チップとはかなり異なるものになるだろう。

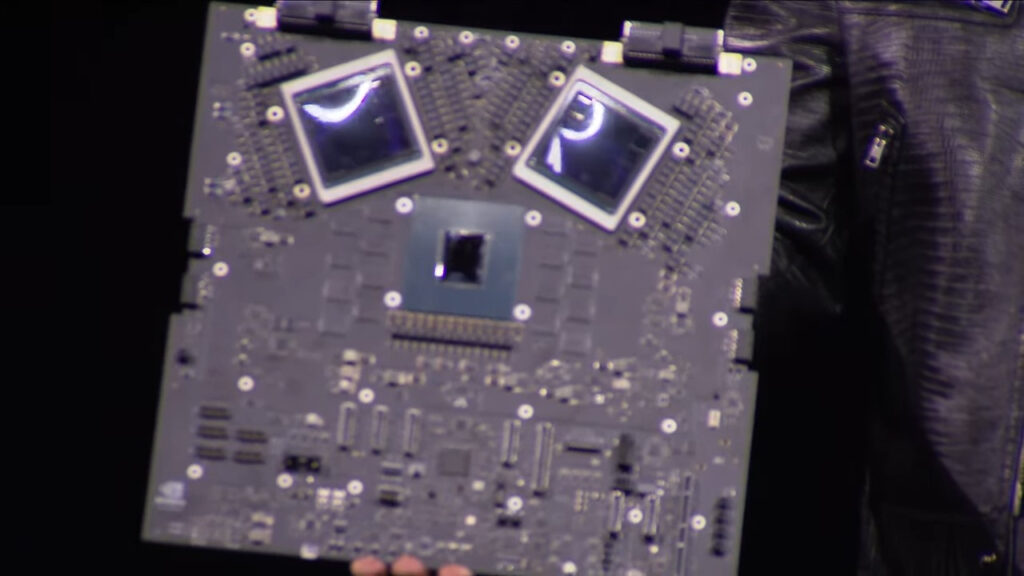

B200は2つのフルレチクルサイズのチップを使用するが、Nvidiaはまだ正確なダイサイズを提示していない。各ダイには、それぞれ24GBのHMB3eスタックが4つあり、1024ビットのインターフェイス上でそれぞれ1TB/秒の帯域幅を持つ。

H100では、各16GBのHBM3スタックが6基搭載されていた(当初は、H200ではこれを24GBの6基に増やした)ため、H100のダイのかなりの部分が6基のメモリコントローラ専用だったことになる。

チップあたり4つのHBMインターフェイスに落とし、2つのチップをリンクさせることで、Nvidiaはメモリ・インターフェイスに割くダイ面積を減らすことができます。

2つ目の注意点は、理論上の最大演算速度20ペタフロップスについてです。

Blackwell B200は、Hopper H100のFP8形式の2倍のスループットで、新しいFP4番号形式によってこの数字に到達する。

つまり、条件を揃えて比較し、FP8にこだわるのであれば、B200はH100(スパース性あり)より理論上のFP8演算が2.5倍多いだけで、その大部分は2つのチップを搭載していることに起因する。

これは、4NPプロセス・ノードによる集積度の大幅な向上が見られないという興味深い点です。

B200は、H100とB200の両方でサポートされているほとんどの数値フォーマットで、理論的にはチップあたり1.25倍のコンピュート密度を実現します。

もちろん、2つのチップ間のNV-HBIインターフェイスもダイ面積を取りますが。

Nvidiaは、B200で他の数値フォーマットの生の計算も提供しており、通常のスケーリング係数が適用されます。

FP8スループットは10ペタフロップスでFP4スループットの半分、FP16/BF16スループットは5ペタフロップスでFP8の半分、TF32サポートは2.5ペタフロップスでFP16の半分です。

繰り返しますが、すべてのケースでH100の2.5倍です。

FP64のスループットは?H100は、GPUあたり60テラフロップスの高密度FP64演算が可能です。

もしB200が他のフォーマットと同様のスケーリングであれば、各デュアルダイGPUは150テラフロップスとなる。

しかし、NvidiaはFP64性能を少し後退させ、GPUあたり45テラフロップスのFP64を搭載するようだ。

しかし、重要なビルディング・ブロックの1つがGB200スーパーチップであるため、この点についても若干の説明が必要だ。GB200は2つのB200 GPUを搭載し、90テラフロップスの高密度FP64が可能で、H100と比較して古典的シミュレーションの生のスループットを向上させる可能性がある。

FP4の活用に関しては、Nvidiaは新しい第2世代のTransformer Engineを持っており、モデルを自動的に適切なフォーマットに変換して最大限の性能を発揮できるようにする。

FP4のサポートに加えて、Blackwellは新しいFP6フォーマットもサポートする。

これは、FP4では必要な精度が不足しているが、FP8も必要ない場合の中間的なソリューションである。

結果の精度がどうであれ、Nvidiaはこのようなユースケースを「Mixture of Experts」(MoE)モデルに分類している。

また、Blackwellには複数の異なるバリエーションがあるため、ここでいくつかのことを明確にする必要がある。

当初、Nvidiaはフルサーバーノードのスペックを提供しており、主に3つのオプションがある。

最大かつ最速のものはGB200スーパーチップで、これについては後述するが、前述の通りB200 GPUを2基搭載している。

フル・スーパーチップのTDPは最大2700Wまで設定可能です。これは、2つのGPUと4つのGPUダイ、そして1つのGrace CPUの場合です。

先ほどの数字、つまりシングルB200で最大20ペタフロップスのFP4は、GB200スーパーチップの半分によるものです。

次のステップはHGX B200で、これは8個のB200 GPUとx86 CPU(おそらく2個のCPU)を1つのサーバーノードで使用することを基本としています。

これらは、B200 GPUあたり最大1000Wまで構成可能で、GPUのFP4スループットは最大18ペタフロップス(GB200のGPUより10%遅い)。

最後に、HGX B100も登場します。これはHGX B200と基本的な考え方は同じで、x86 CPUと8基のB100 GPUを搭載している。

ただし、既存のHGX H100インフラとドロップイン互換性があり、Blackwell GPUを最も迅速に導入できるように設計されている。

そのため、GPUあたりのTDPはH100と同じ700Wに制限され、スループットはFP4の14ペタフロップスに低下する。

これらの3つのサーバーすべてにおいて、HBM3eはGPUあたり同じ8TB/秒の帯域幅であると思われるため、GPUコアクロックとおそらくコア数とともに電力だけが異なっているように見えることに注意することが重要です。

Nvidiaは、Blackwell GPUで利用可能なCUDAコア数やストリーミング・マルチプロセッサの詳細については、まだ明らかにしていない。

未加工のコンピュートやメモリの帯域幅だけではありません。AIやHPCワークロードにおける大きな制限要因の1つは、異なるノード間の通信のためのマルチノードインターコネクト帯域幅です。

GPUの数が増えるにつれて、通信が深刻なボトルネックとなり、利用されるリソースと時間の最大60%を占めることがあります。

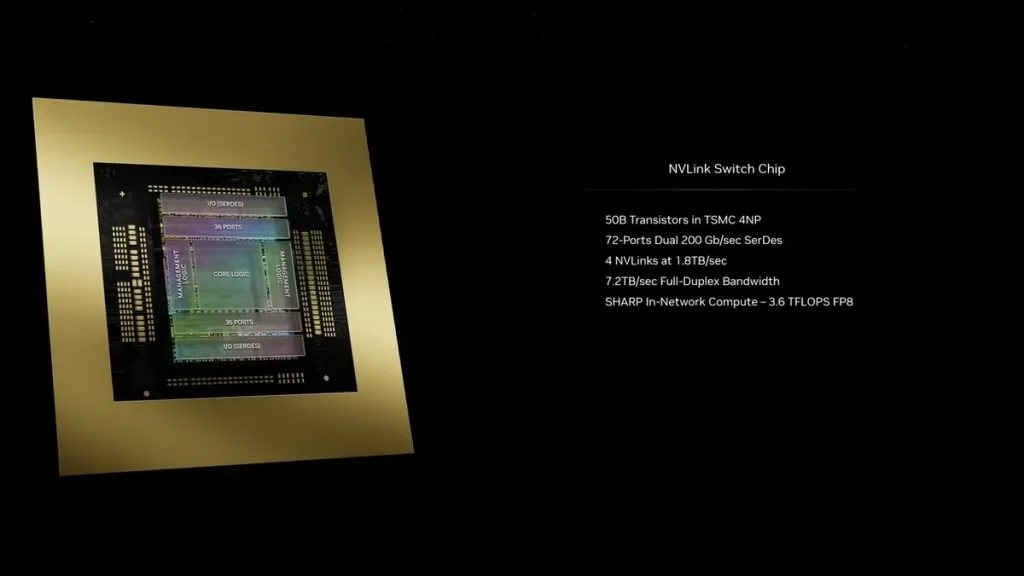

B200で、Nvidiaは第5世代のNVLinkとNVLinkスイッチ7.2Tを導入します。

新しいNVLinkチップは、1.8TB/秒の全対全双方向帯域幅を持ち、576 GPU NVLinkドメインをサポートします。

これは、同じTSMC 4NPノードで製造された500億トランジスタのチップです。

このチップは、チップ上で3.6テラフロップスのSharp v4インネットワーク・コンピュートもサポートしており、大型モデルの効率的な処理に役立ちます。

前世代では、HDR InfiniBandの帯域幅は最大100GB/秒をサポートしていたので、これは帯域幅の大きなジャンプです。新しいNVSwitchは、H100マルチノードインターコネクトと比較して18倍のスピードアップを提供します。

これにより、より大規模な兆パラメータモデルのAIネットワークのスケーリングが大幅に改善されるはずです。

これに関連して、各Blackwell GPUには18個の第5世代NVLink接続が装備されている。

これはH100の18倍のリンク数だ。各リンクは、50 GB/秒の双方向帯域幅、つまり1リンクあたり100 GB/秒の帯域幅を提供します。

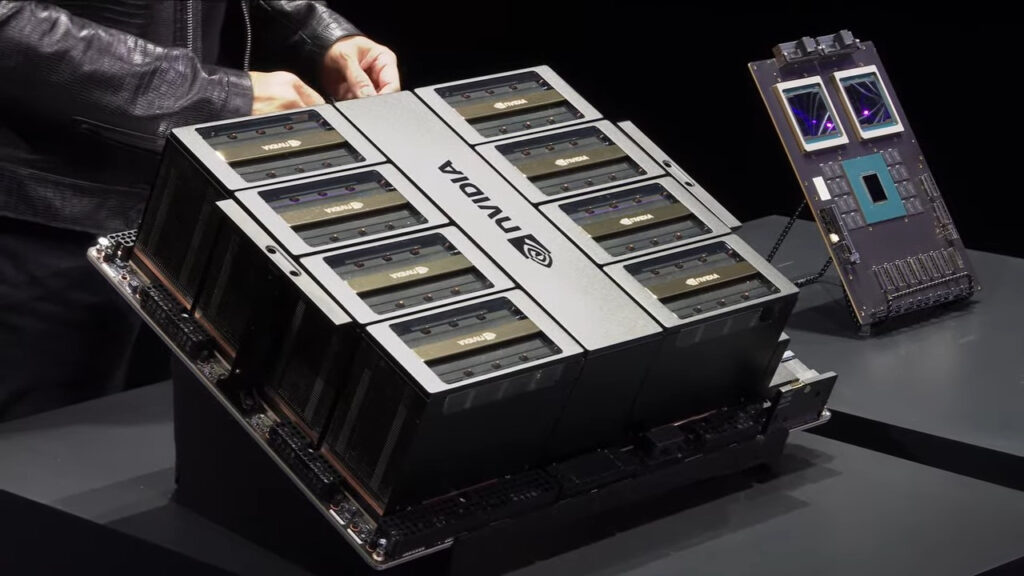

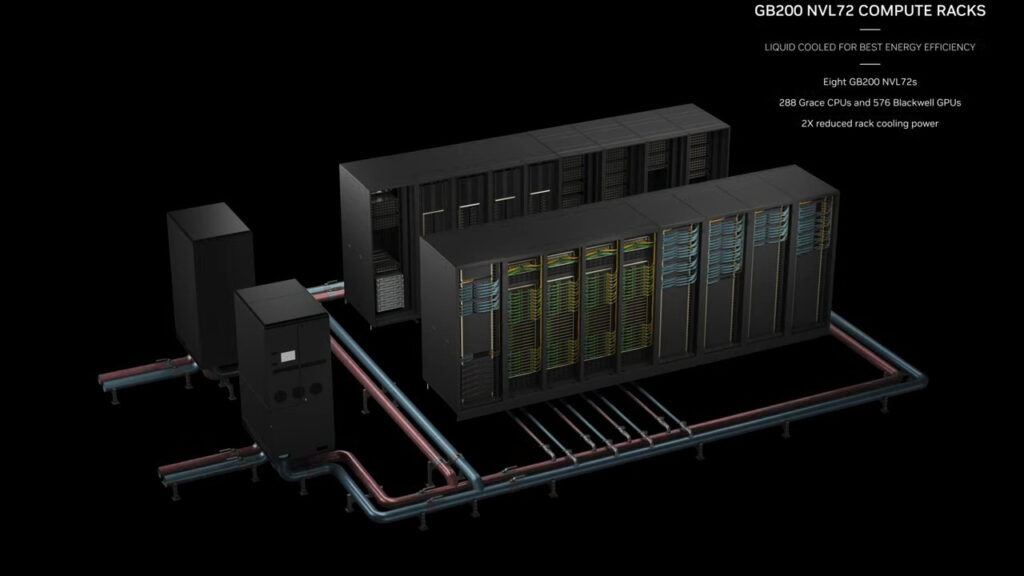

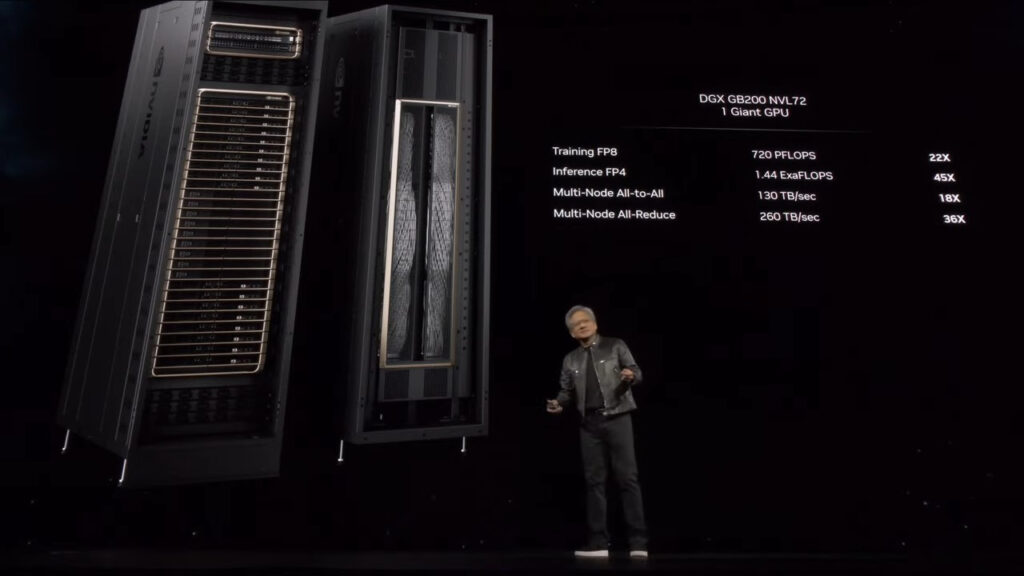

以上をまとめると、Nvidiaの新しいGB200 NVL72システムになります。これらは基本的にフルラック・ソリューションであり、18台の1Uサーバーがそれぞれ2つのGB200スーパーチップを搭載している。

しかし、GB200スーパーチップを構成する要素という点で、前世代とは若干の違いがあります。

画像とスペックから、2つのB200 GPUが1つのGrace CPUにマッチしていることがわかるが、GH100では、1つのGrace CPUと1つのH100 GPUを並べる小規模なソリューションが採用されていた。

その結果、GB200スーパーチップのコンピュート・トレイには、2基のGrace CPUと4基のB200 GPUが搭載され、FP4 AI推論で80ペタフロップス、FP8 AIトレーニングで40ペタフロップスの性能を発揮することになる。

これらは液冷式1Uサーバーであり、ラック内に提供されるtypica 42ユニットのスペースの大部分を占める。

GB200 NVL72には、GB200スーパーチップコンピュータトレイの他に、NVLinkスイッチトレイも搭載されます。

これらも1Uの液冷トレイで、1トレイあたり2台のNVLinkスイッチを搭載し、1ラックあたり9台のトレイを搭載します。

各トレイは、14.4TB/秒の総帯域幅に加え、前述のSharp v4コンピュートも提供します。

合計すると、GB200 NVL72は、36個のGrace CPUと72個のBlackwell GPUを搭載し、720ペタフロップスのFP8と1,440ペタフロップスのFP4コンピュートとなります。

マルチノード帯域幅は130TB/秒であり、Nvidiaによれば、NVL72はAI LLM向けに最大27兆個のパラメータモデルを扱うことができるという。

解説:

GB200を使ったB200は現世代のH100より推論で30倍、学習で4倍高速になる。

GB200のアーキテクチャーを見て、ゲーム用のGB202に対する予想(憶測)も少しインスピレーションを感じるところがありましたので説明しようと思います。

まずGB200は条件をそろえて比較するとH100の2.5倍の性能とのことです。

同じTSMC4NPなので2.5倍のうち、大部分は2つのチップを搭載していることがその要因のようですね。

ですから、1チップあたり1.25倍になるようです。

あくまでも30倍はFP4を使った時の性能であるようです。

このことから次期GeforceのGB202とDLSS4はFP4の演算がカギを握ているのではないかと思います。

DLSSという仕組みの中で演算性能を純粋に反映させるのは無理だと思いますので、さすがに30倍は難しいと思いますが、わたくしが以前から予想している10倍程度の性能向上なら楽に達成できるのではないか思います。

つまりRTX4000+DLSS3 VS RTX5000+DLSS4は10倍の性能になるということですね。

そのカギを握っているのはここにも出てきているFP4演算だと思います。

正直、FP4だと精度があまりに低すぎるのではないかと思いますがGB200でNVIDIAが例に挙げるということはある程度の実用性はあるんじゃないかと思い須磨。

RTX5000はTSMC3nmを使うといわれていますので、ダイサイズはおそらく同等で性能が向上するのではないかと思います。

今回のGB200の話を見て感じたことですので当たってるかどうかまでは断言できませんが、DLSSの場合、推論が高速化されれば、フレームレートの伸長にかなり恩恵が大きいと思いますので可能性はあるのかなと思います。

nVidia RTX4000SUPER

nVidia RTX4000

nVidia RTX3000シリーズGPU

RTX3060 12GB GDDR6

RTX3050 6GB