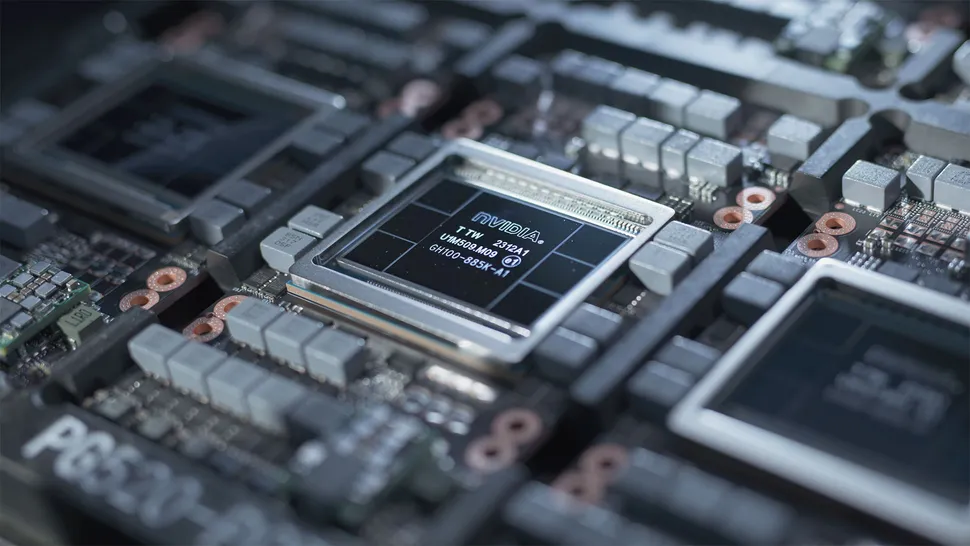

AIやHPC向けのプロセッサーとしてはかなりのパワーだ。

世界最大のサーバーメーカーのひとつであるデルは、コードネーム「Blackwell」と呼ばれるNvidiaの次期AI GPUについて情報を漏らした。

どうやら、これらのプロセッサーの消費電力は最大1000ワットで、旧世代に比べて40%増加するため、デルはこれらのGPUを冷却するために工学的な工夫を必要とするようだ。

デルのコメントは、Nvidiaの次期コンピュートGPUのアーキテクチャ上の特殊性を示唆しているかもしれない。

「デルの最高財務責任者(CFO)であるイヴォンヌ・マクギルは、「明らかに、H200とその性能向上で何が起きているのかに興奮していることは、どのような変化を見ても明らかだ。

「私たちは、B100とB200で何が起こるかに興奮しており、そこにエンジニアリングの自信を際立たせる別の機会があると考えています。

熱的な側面における我々の特性は、GPUあたり1,000ワットのエネルギー密度を得るために、直接液冷を必要としないことです。

| Nvidia H100 (現在) | Nvidia B100 (Dell est.) | AMD MI300X | Nvidia H200 (現在) | |

| FP16/bf16 TFLOPS | 989 | ? | 1,307 | 989 |

| 消費電力 | 700W | 1000W | 750W | 700W |

| ダイサイズ (平方mm) | 814 | ? | 1,017 | 814 |

Blackwell・アーキテクチャに関するNvidiaの計画を知らないため、熱放散に関する基本的な経験則を参照するしかない。

チップ製造の観点からは、ここが興味深いところだ: NvidiaのH100(4nmクラスのカスタム・プロセス技術で製造)は、HBMメモリの電力を含むとはいえ、すでに約700Wを放熱しており、チップダイは814^2の大きさなので、1平方ミリあたり1Wを下回る。このダイは、TSMCのカスタム・パフォーマンス強化4nmクラス・プロセス技術で作られている。

Nvidiaの次世代GPUは、おそらく別の性能向上プロセス技術で製造され、3nmクラスのプロセス技術で製造されると推測できる。

チップが消費する電力量と必要な放熱を考慮すると、NvidiaのB100は同社初のデュアルダイ設計になるかもしれないと考えるのが合理的だ。

AMDやIntelが複数のダイを持つGPUアーキテクチャを採用するのはすでに見てきたことであり、これは他の業界のトレンドに沿ったものだろう。

高性能のAIやHPCアプリケーションに関しては、FLOPSで測定される性能と、そのFLOPSを達成するために必要な電力、そしてその結果生じる熱エネルギーを冷却することを考慮する必要がある。

ソフトウェア開発者にとって重要なのは、これらのFLOPSをいかに効率的に使用するかである。

ハードウェア開発者にとって重要なのは、FLOPSを生み出すプロセッサをいかに冷却するかである。

デルのCFOがNvidiaの次世代GPU「Blackwell」について語ったのはこのためだ。

「それは来年、B200で実現します」と、マクギルはNvidiaの次期AIおよびHPC GPUについて語った。"私たちにとって、エンジニアリングと、私たちがどれだけ速く動けるか、そして、液冷を大規模に実行させるための私たちの専門知識を提供するために、業界のリーダーとして行ってきた作業を披露する機会は、流体の化学的性質や性能、相互接続の作業、私たちが行っているテレメトリー、私たちが行っている電源管理の作業など多岐にわたります。

解説:

nVIDIAの次期AI/MLハードウェアアクセラレーターは一発1000Wクラス

nVIDIAのサーバー向け次期AI/MLハードウェアアクセラレーターは一基1000Wの消費電力だそうです。

サーバー向け製品の消費電力はなぜこんなに無茶苦茶なのかでいうと、まず、サーバーは投資額が大きく、効率の高さが求められるため、ある程度のスケールがあったほうが有利であること、一般家庭のような電源の制限が比較的無い、もしくは小さいこと、騒音が無視できる環境であること、空調が完備されていることなどが挙げられます。

一般家庭のように真夏でもクーラーがないなどという貧乏くさい環境であることなどまず全くあり得ません。

フェラーリオーナーなのに車庫がないと言ってるのと同じくらいあり得ません。

ユースケースによっては値段のつけられないデータを扱っている可能性がありますので当然です。

また、基本的に分厚いコンクリート壁の向こう側にあるため、飛行機の爆音のような音がするファンをつけて冷却しても関係ないことなどが挙げられます。

また、木造家屋と違って床面の耐荷重も大きいです。

こういう環境なので、サーバー向けの製品を安易に家庭に持ち込むのは感心しません。

生活環境で使うことなど全く考慮されてないことも多いので、スイッチオンにした瞬間に近所からクレームが入りまくるような爆音が轟いたりする可能性もあるわけです。(苦笑。

で、家庭用のブレーカー一個当たり100V、1500Wの制限を無視できる可能性もあるので、GPU一発あたり1000wなどという途方もない消費電力でも全く問題ないということになります。

どのみち機材は数億円単位で入れるので一定の効率をクリアしているか=演算量当たりのランニングコストが高いか低いかが重要ということになります。

ラックマウントサーバートータルで100台、全部で20万ワットの消費電力がかかるのに、一台当たりの消費電力など気にしても仕方ないということです。(苦笑。

こんな風にあらゆる面で家庭用PCとは求められるものが違いますので、同じ基準では測れないということになります。

我々としてはRTX5090が600Wに収まることを祈りましょう。

次世代は6スロットくらいになるかもしれせんね(苦笑。