NvidiaのBlackwellは2024年に登場し、後継モデルは2025年に市場に投入される。

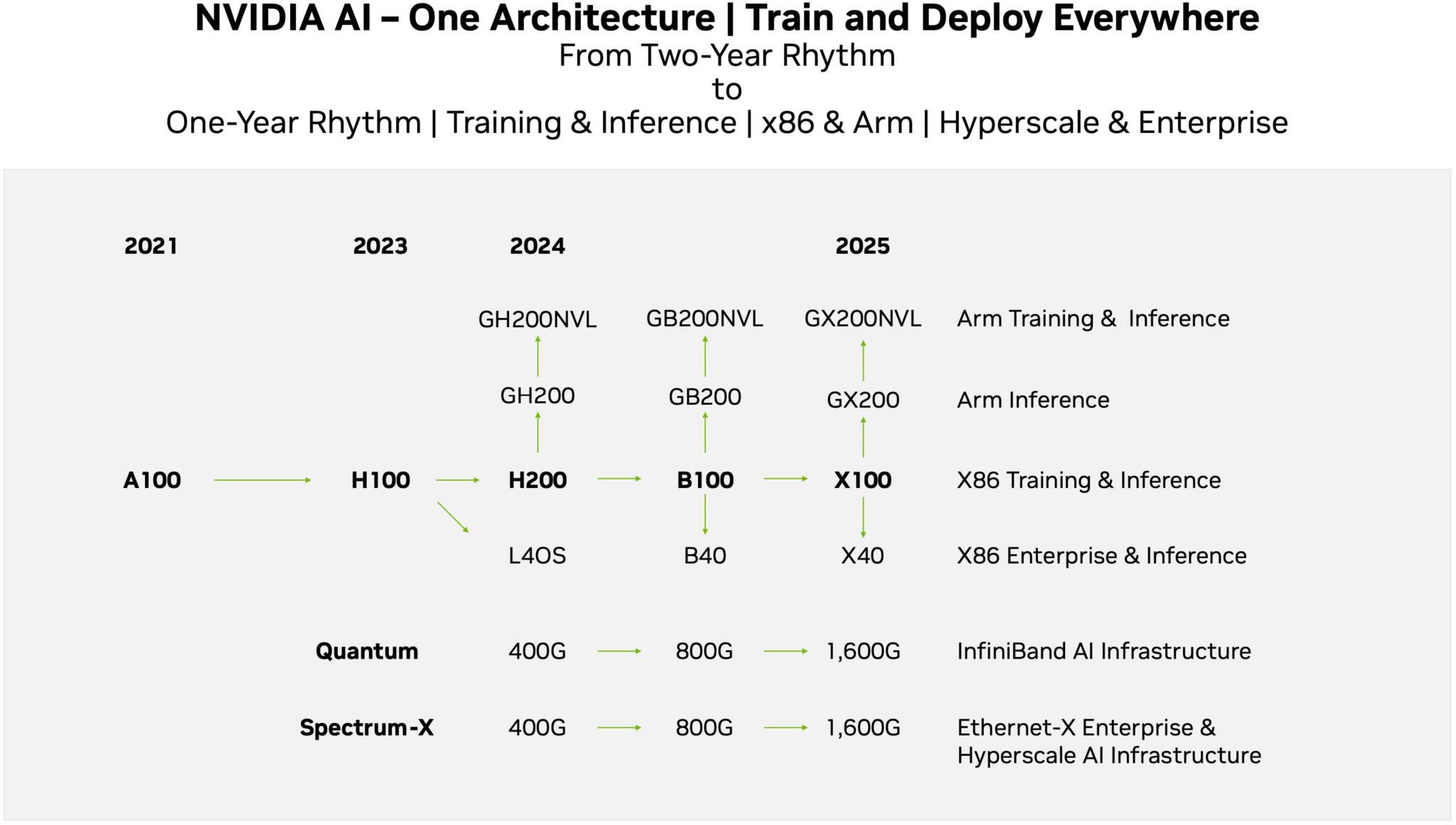

Nvidiaは、人工知能(AI)およびハイパフォーマンス・コンピューティング(HPC)ハードウェアにおけるリーダーシップを維持するために、新しいGPUアーキテクチャの開発を加速し、実質的に製品導入の1年サイクルに戻す計画であると、投資家向けに発表されたロードマップとSemiAnalysisがさらに詳しく説明した。

その結果、NvidiaのBlackwellは2024年に登場し、2025年には新アーキテクチャに引き継がれることになる。

しかし、Blackwellが来年(おそらく来年後半)登場する前に、NvidiaはHopperアーキテクチャに基づく複数の新製品を展開する予定である。

これには、歩留まりを向上させるためにH100を再回転させたものかもしれないし、単に高性能にしたものかもしれないH200製品や、ArmベースのCPUとHopperベースのGPUで大規模な言語モデルのトレーニングと推論に対応するGH200NVLが含まれる。

これらは遅かれ早かれ登場する予定だ。

2024年に予定されているBlackwellファミリーについては、NvidiaはH100の後継となるx86プラットフォーム上のAIおよびHPCコンピュート向けのB100製品を準備しているようだ。

さらに、Arm CPUとHopper GPUを搭載したGrace Hopperモジュールと思われるGB200と、LLMトレーニングと推論用のArmベースのソリューションであるGB200NVLも準備している。

また、同社は、AI推論用のクライアントGPUベースのソリューションと推定されるB40製品を計画している。

2025年、Blackwellは「X」の文字が付けられたアーキテクチャに引き継がれる予定だが、これは現時点でのプレースホルダーであろう。

いずれにせよ、Nvidiaは、x86のAIトレーニングと推論、およびHPC向けのX100、Arm推論向けのGX200(Grace CPU + X GPU)、ArmベースのLLMトレーニングと推論向けのGX200NVLを準備している。

さらに、低コスト推論用のX40製品(おそらくクライアントGPUベースのソリューションに基づく)も用意される。

今のところ、NvidiaはAI GPU市場をリードしているが、AWS、グーグル、マイクロソフト、そしてAMDやNvidiaのような従来のAIやHPCのプレーヤーは皆、トレーニングや推論用に新世代のプロセッサを準備しており、NvidiaがB100とX100ベースの製品の計画を加速させたと報じられたのはそのためだ。

Nvidiaはその地位をさらに強固なものにするため、TSMCの容量とHBMメモリーを3つのメーカーすべてから事前購入したと伝えられている。

さらに、同社はHGXサーバーとMGXサーバーを推し進め、これらのマシンをコモディティ化し、特にエンタープライズAI分野でエンドユーザーに普及させようとしている。

ソース:Tom's Hardware - Nvidia May Move to Yearly GPU Architecture Releases

解説:

nVIDIAが製品更新サイクルを1年に変更する・・・・が。

これはあくまでAI/ML用製品の話で、ゲーム用の製品であるGeforceがどうなるのかは未知数だと思います。

今までnVIDIAは結構な力をゲーム用製品に入れていたと思います。

しかし、ちょっと前に900トンものAI/MLむけGPUを出荷したとの話もありましたし、利益率900%と言う話もありました。

それを考えるとあまりおいしくないし在庫もダブ付いているGeforceに同様の力を入れるかと言ったら難しいと思います。

Geforceが1年後との交信になるのかどうかと言うのはわかりませんが、もしこの話に引っ張られて1年になるとしたら生産上の都合しかありえません。

製造プロセスは1年ごとに更新されるわけではありませんので、どっちにしてもFabは押えるのでしょうから、ゲーム用GPUは1年更新の恩恵を受けられない可能性もあるのかなと思います。

今のところRTX3060は店頭にあふれていますので、これ以上、Geforceを市場に投入する意味と言うのはあまりありません。

来年に入ればある程度はっきりすると思いますので、続報が出たらお知らせします。

AI/ML製品は一世代変わると性能が全く変わってしまうため、

nVidia RTX4000SUPER

nVidia RTX4000

nVidia RTX3000シリーズGPU

RTX3060 12GB GDDR6

RTX3050 6GB