nVIDIAは1月にシリーズBの資金調達に参加している。

nVIDIAのジェンセン・フアンCEOは、Wiredとの幅広いインタビューの中で、個人的にPerplexity AIをお気に入りのAIチャットボットとして活用していることを明らかにした。

ChatGPTやBardのようなツールの使用について尋ねられたフアン氏は、あまり知られていないこのチャットボットを好んで使用していることを明らかにした。

インタビューでの答えによると、Huang氏はPerplexity AIとChatGPTの両方を「ほぼ毎日」使用しているという。

我々は、Bard /Geminiや GrokのようなAIのライバルは、現在のところ、グリーンチームのお墨付きを得るためのグレードには達していないと推測している。

では、フアンはAIチャットボットを何に使っているのだろうか?nVIDIAのCEOは、チャットボットを研究に使っていると説明する。

現在、フアンはコンピューター支援による創薬に特に興味を持っているようだ。

これが科学的かつビジネス的な興味であり、愛する人が心配な健康問題を抱えているからではないことを祈りたい。

Perplexityの魅力は、”世界初の会話型回答エンジン “と自称していることからも明らかだろう。

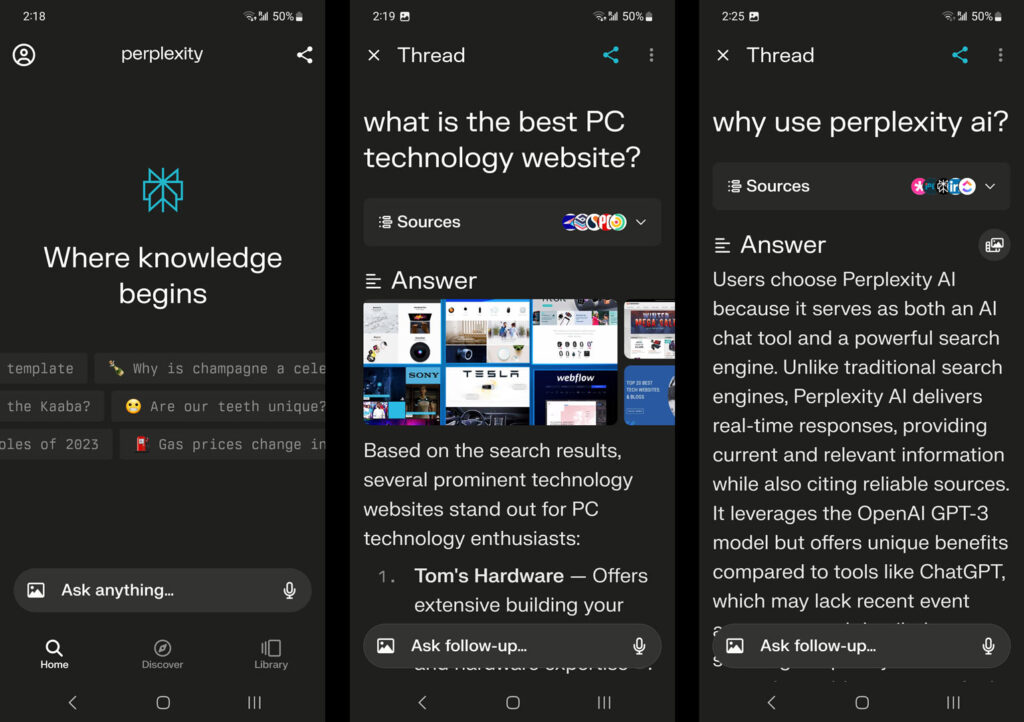

実際、私たち自身がアプリを使ったり、ウェブサイトからPerplexityを使ったりしてみたところ、素早く簡単に問い合わせができ、トピックを深く掘り下げることが自然にできることがわかった。

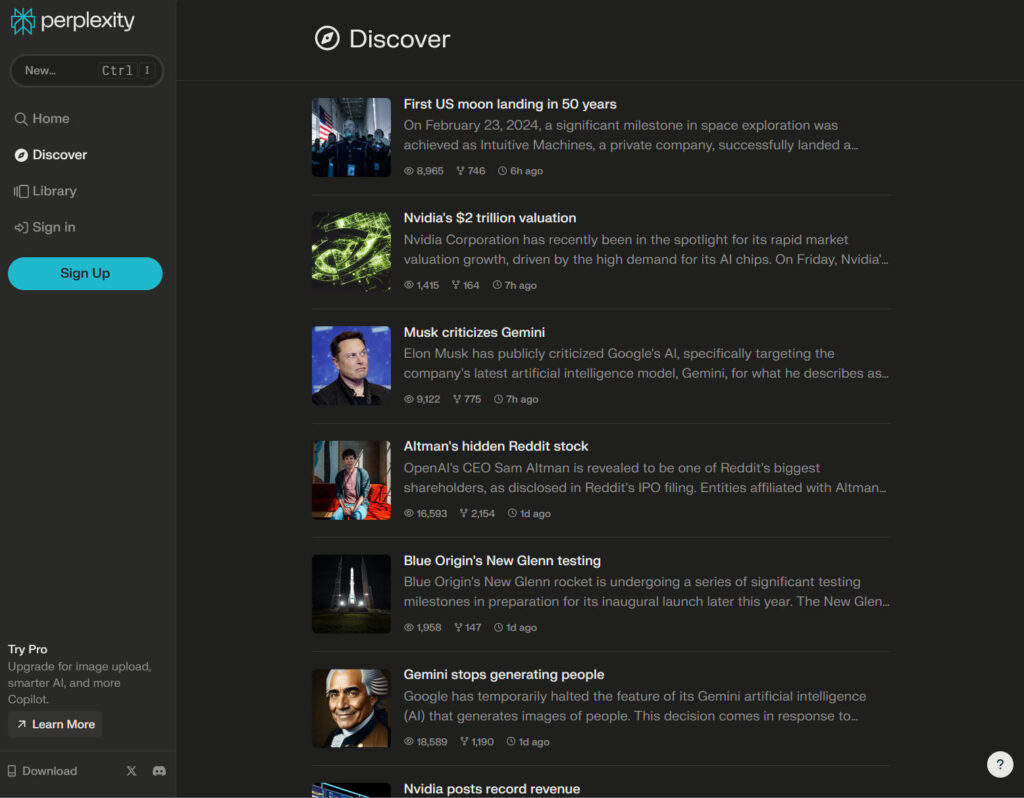

Perplexityはまた、過去のクエリースレッドの便利な「ライブラリ」や、ニュースや時事問題の「発見」フィードも提供している。

上のスクリーンショットでは、PerplexityのシンプルなUI、PCテックサイトでの優れたセンス、そして開発者が自分たちのアプリを優れた選択だと考える理由を見ることができる。

nVIDIAは多くのAIのパイに指を突っ込んでいるが、2024年1月にはIVPが主導する7,360万ドルのシリーズB資金調達ラウンドに参加している。

このことを考えれば、ジェンセン・フアンがPerplexity AIに注目し、何人かの幹部がこの製品を「ドッグフーディング」していることは、それほど驚くことではないだろう。

Perplexity AIのウェブサイトとアプリは無料で利用できるが、有料版であるProサブスクリプションを利用することで、より多くの機能と能力をアンロックすることができる。

このチャットボットを楽しむ人は、無制限のMicrosoft Copilotクエリ、AIモデルの選択(GPT-4、Claude 2.1、またはPerplexity)、無制限のファイルアップロード、毎月5ドルの生成AIクレジットなどのために、毎月20ドルまたは年間200ドルの料金を支払いたくなるかもしれない。

その他のインタビュー

個人的なAIチャットボットの好みの話題は、ワイアードのローレン・グッドとの長いインタビューのほんの一部に過ぎなかった。

当然ながら、2024年には多くのAIトピックが取り上げられている。より興味深いナゲットのひとつは、新しいタイプのデータセンターに関するホアンの説明だった。

nVIDIAのCEOは、数年前から開発が進められているという「AIファクトリー」について概説した。

これは発電機に例えられており、nVIDIAでは製品化の目処が立っているという。

私たちの関心を高めたもう1つのトピックは、ムーアの法則についての議論だった。

フアン氏は、nVIDIAがメラノックスを買収したのは、データセンター規模でムーアの法則を回避するためだと説明した。

また、フアン氏がモリス・チャン氏のようなTSMCのトップと頻繁に話をしていることも聞いた。

ホットな話題としては、CoWoSのような高度なパッケージング、容量計画、関連する新技術などがある。

しかし、AI GPUの待ち時間や次期Blackwell世代についてのより具体的な質問に対しては、nVIDIAのボスは異例なほど(しかし当然ながら)逃げ腰だった。

解説:

nVIDIAのCEOジェンセン・ファン氏のお気に入りAIはPerplexity AIとChat GPT

Perplexity AIはわたくしは勉強不足で知りませんでした。

日本ではあまり有名でないように思えます。

AI/MLアクセラレーターの雄であるnVIDIAのCEOがGoogleのBardやGeminiを選ばずにこれらのAIを選んでいるのは頭一つ抜けているからなのでしょう。

なんでもAIを使った創業の支援に興味があるのだとか。

今は他社もこぞってAI/MLアクセラレーターの開発に乗り出しています。

nVIDIAに追いつけるのかどうかまではわかりませんが、多少劣っていたとしても今のnVIDIA製品はかなりの高額になっており、あのMSですらもその調達コストに根を上げているそうですので、自社で使う分にはよいのだと思います。

これらのAI/MLアクセラレーターが世に出るまでの数年間・・・2-3年から長くて5年程度が一番nVIDIAの業績が良い時ではないかと思います。

昔からGPUを開発していたAMDや最近単体GPUの開発に乗り出したIntelなどはすぐに製品を投入できると思いますが、その他の企業で今のnVIDIAの一世代前と同等の製品を出してくるのは並大抵のことではないと思います。

ROCmのセットアップスクリプトを作っているとわかりますが、AMDはAIに関してはnVIDIAの一世代遅れですね。

RDNA3はAmpereと同等か少し劣るくらいです。

画像生成AIに関してはRX7900XTXはxformersが使えないRTX3090といった感じです。

メモリ搭載量も同じですし、速度も似たような感じです。

ゲーム性能が少し上で総合的にみるとnVIDIAの0.5世代遅れといった感じです。

一番差がついているのはAI/MLの分野だと思います。

RDNA3はRDNA2と比較すると1SP当たり2演算器になりましたので、AmpereからTuringへの進化と非常によく似ています。

RDNA2はStablediffusion WebUIのオプションで「–no-half」を指定するのが定番でしたが、RDNA3でそれをやるとかなり遅くなりますし、「–upcast-sampling」を指定しても全く早くならないので、本当にまんまAmpereといった感じに見えますね。

われわれが興味のある次期GPUであるBlackwellやAI GPUの供給に関してはかたくなに口を閉ざしていたようですね。

まあ、当然でしょう。